'Critique de LTX-2 (LTX Video) : Le premier modèle "Audio-Visuel" Open Source'

Juste au moment où nous pensions que la guerre de la vidéo IA se calmait entre Hunyuan et Wan 2.1, Lightricks a lâché une bombe. LTX-2 (anciennement connu sous le nom de LTX Video) a été officiellement publié avec des poids ouverts (open weights), et ce n'est pas juste un autre générateur vidéo.

C'est le premier modèle de fondation à poids ouverts au monde capable de génération audiovisuelle conjointe — ce qui signifie qu'il crée la vidéo et l'audio synchronisé simultanément en une seule passe.

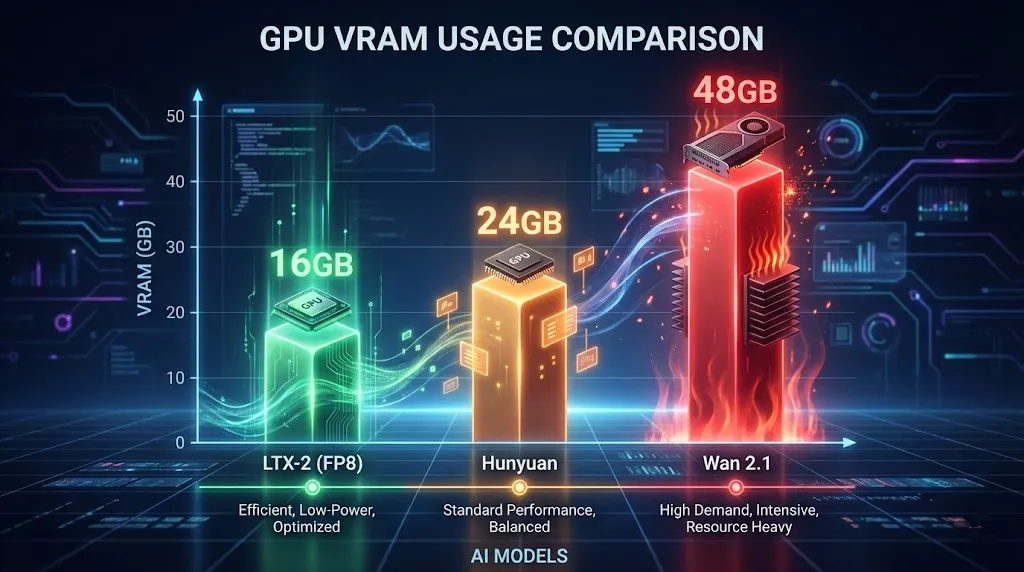

Mais le vrai titre pour les utilisateurs locaux ? Efficacité. Contrairement au Hunyuan Video gourmand en VRAM, LTX-2 tourne confortablement sur des GPU grand public de 16 Go (en utilisant la quantification NVFP8), offrant des vitesses de génération quasi temps réel qui donnent l'impression que les autres modèles font leur rendu au ralenti.

Si vous cherchez un générateur vidéo IA open source en 2026 qui génère du son et ne fera pas fondre votre GPU, c'est celui-ci. Dans ce guide, nous plongerons dans les spécifications, comparerons LTX-2 vs Hunyuan Video, et vous montrerons comment l'utiliser immédiatement.

L'Innovation : Génération Audio-Vidéo Conjointe

Lightricks a résolu un énorme point sensible : le design sonore. Construit sur une nouvelle architecture DiT (Diffusion Transformer), LTX-2 comprend la corrélation entre le mouvement et le son.

- Comment ça marche : Quand vous promptez « un verre qui se brise », le modèle génère instantanément les éclats volants visuellement et le son synchronisé du verre qui casse.

- Pourquoi c'est important : Plus besoin de chercher des effets sonores libres de droits ou d'essayer de synchroniser laborieusement l'audio en post-production. Tout est généré nativement.

Spécifications Clés

- Résolution : Support 4K natif (Optimisé pour 720p sur GPU locaux).

- Fréquence d'images : Jusqu'à 50 FPS pour un mouvement fluide (le standard est 24 FPS).

- Audio : Génération audio synchronisée native (stéréo 48kHz).

- Licence : Gratuit pour usage commercial (pour les entités avec <10M$ de revenus annuels).

Configuration Matérielle : Pouvez-vous le faire tourner ?

C'est là que LTX-2 brille. Alors que Run LTX Video locally 24GB VRAM est idéal pour la 4K, le modèle utilise la quantification NVFP8 pour s'adapter aux cartes milieu de gamme.

Spécifications Minimales pour 720p (4 Secondes)

- GPU : NVIDIA RTX 3080 / 4070 Ti / 4080 (12 Go - 16 Go de VRAM).

- RAM : 32 Go de RAM système.

- Stockage : 50 Go d'espace SSD.

Pour ceux qui demandent, "Run LTX Video locally 16GB VRAM" — Oui, absolument. En activant l'encodeur de texte FP8 et les poids du modèle dans ComfyUI, vous pouvez générer des clips 720p / 24fps / 4s sans rencontrer d'erreurs OOM (Out of Memory).

LTX-2 vs Hunyuan Video : L'Affrontement

Nous avons testé les deux modèles de manière extensive. Voici le verdict pour 2026.

| Fonctionnalité | LTX-2 (Lightricks) | Hunyuan Video | Wan 2.1 |

|---|---|---|---|

| Audio | Synchro Native (Gagnant) | Non | Non |

| Vitesse | Rapide (FP8) | Modérée | Lent (Haute Qualité) |

| VRAM | Ami des 16 Go | 24 Go+ Recommandé | 48 Go+ (Entreprise) |

| Cohérence | Bonne (Clips courts) | Excellente | Meilleur de sa catégorie |

| Licence | Communauté (<10M$) | Open Source | Open Source |

Verdict : Choisissez LTX-2 pour le contenu réseaux sociaux, les visualisateurs musicaux, et les scénarios où le son est crucial. Choisissez Hunyuan ou Wan 2.1 si vous avez besoin d'une cohérence visuelle de niveau Hollywood et que vous ne vous souciez pas de l'audio.

Tutoriel : Comment utiliser LTX-2 (En ligne vs Local)

Vous avez deux options pour faire tourner ce modèle.

Option 1 : La manière la plus simple (Recommandé)

Vous n'avez pas besoin d'un GPU à 2000 $ pour utiliser LTX-2. Nous avons intégré le modèle complet directement dans notre plateforme.

- Aucune installation requise.

- Génération rapide sur notre cloud.

- Prévisualisation audiovisuelle instantanée.

Essayez LTX-2 en ligne maintenant (Cliquez pour commencer à générer).

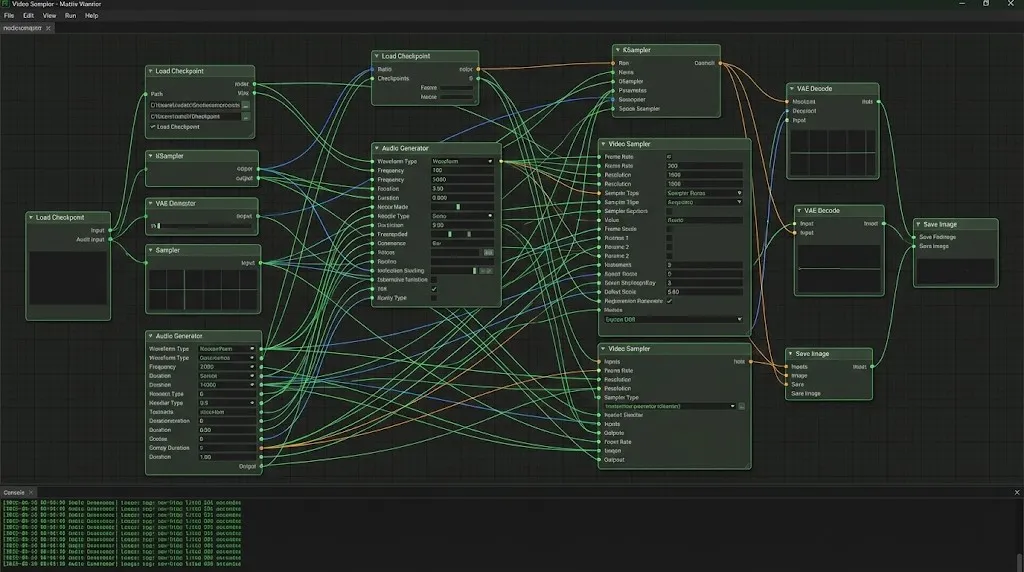

Option 2 : Configuration ComfyUI Locale (Pour les développeurs)

Si vous préférez le faire tourner localement, suivez ces étapes :

- Installer les Custom Nodes : Recherchez

ComfyUI-LTXVideodans Manager. - Télécharger les Poids : Obtenez

ltx-video-2b-v0.9.safetensors(version FP8) sur Hugging Face. - Charger le Workflow : Construisez un workflow standard connectant le LTX Loader au Sampler.

- Lancer : Réglez les frames sur 97 (env. 4 secondes) et profitez.

Conseil Pro : La configuration locale nécessite souvent de dépanner des dépendances Python. Si vous rencontrez des erreurs, nous recommandons de passer à notre outil en ligne pour une expérience sans tracas.

Conseils d'Ingénierie de Prompt LTX-2

Obtenir de bons résultats nécessite des stratégies de prompt spécifiques. LTX-2 comprend à la fois les signaux visuels et auditifs.

1. Prompts Audio-Visuels

Décrivez le son à l'intérieur de votre prompt visuel :

- Prompt : "A cinematic shot of a thunderstorm, lightning strikes a tree, loud thunder crack, rain pouring sound."

- Résultat : Le modèle synchronisera l'éclair lumineux avec le pic audio du tonnerre.

2. Contrôle de Caméra

Utilisez ceci pour diriger le plan :

LTX Video camera control prompts: "Camera pan right", "Slow zoom in", "Drone shot", "Low angle".- Exemple : "Cinematic drone shot flying over a cyberpunk city, neon lights, fog, 4k, highly detailed, electronic synthesizer music background."

3. La Liste de Prompts Négatifs

Pour éviter l'effet de "visage fondant" courant dans les modèles rapides, utilisez cette liste de prompts négatifs LTX Video :

"Blurry, distorted, morphing, jittery, watermarks, text, bad anatomy, static, frozen, silence, muted."

FAQ : Dépannage et Optimisation

Q : Ma génération locale est juste un écran noir.

R : Cela arrive généralement si vous utilisez le mauvais dtype VAE. Assurez-vous que votre VAE est réglé sur bfloat16 si votre GPU le supporte, ou float32 si vous êtes sur des cartes plus anciennes.

Q : Les réglages 720p de LTX-2 font planter mon PC.

R : Activez --lowvram dans votre fichier bat ComfyUI. Assurez-vous également que votre "nombre de frames" suit la formule (8 * n) + 1 (par ex. 97, 121) pour un alignement tensoriel optimal.

Q : Puis-je utiliser ceci commercialement ? R : Oui ! Si vos revenus annuels sont inférieurs à 10 millions de dollars US, la Licence Communautaire LTX-2 autorise une utilisation commerciale complète.

Conclusion

Lightricks LTX-2 est un moment charnière pour l'IA open source. C'est la première fois que nous avons un modèle qui combine vitesse, audio, et accessibilité dans un seul paquet.

Bien qu'il ne batte peut-être pas Wan 2.1 en cohérence brute au pixel près, la capacité de générer des clips audiovisuels synchronisés est révolutionnaire. Pour la plupart des créateurs, LTX-2 est l'outil qui amène enfin le son à la fête de la vidéo IA.

'Critique de Seedance 1.5 Pro : Le chef-d''œuvre audiovisuel de ByteDance avec un Lip-Sync parfait'

'Alors que LTX-2 a ouvert la porte, Seedance 1.5 Pro la perfectionne. Découvrez la génération audiovisuelle native, le lip-sync précis et le contrôle de caméra complexe en ligne.'

Kling 3.0 est sorti : Le guide ultime des fonctionnalités, prix et accès

Kling 3.0 est là ! Découvrez le nouveau moteur créatif intégré avec sortie 4K, Burst Mode de 15-second et effets visuels cinématographiques. Apprenez comment y accéder dès aujourd'hui.

J'ai testé Kling 3.0 Omni : Séquences de 15s, Audio Natif et la Vérité sur Gen-4.5

Kling 3.0 Omni est-il le tueur de Runway Gen-4.5 ? J'ai passé 24 heures à tester la génération native de 15 secondes, la précision du lip-sync et les contrôles multi-caméras. Voici le verdict.

Kimi k2.5 est sorti : Le partenaire ultime pour le workflow vidéo Kling 2.6

Kimi k2.5 est là avec une compréhension vidéo native et une fenêtre contextuelle de 256k. Apprenez comment le combiner avec Kling 2.6 pour automatiser votre pipeline de production vidéo IA.

Z-Image Base vs Turbo : Maîtriser le rendu de texte chinois dans les vidéos Kling 2.6

Apprenez à utiliser les modèles Z-Image Base et Turbo pour résoudre les problèmes de rendu de texte chinois dans les vidéos Kling 2.6. Guide complet du flux de travail pour les cas d'utilisation commerciaux et artistiques.

'Briser le monopole de Nvidia : Comment GLM-Image et la puce Ascend de Huawei ont conquis les classements IA'

'Le 14 janvier, GLM-Image, entièrement entraîné sur les puces Ascend de Huawei et le framework MindSpore, a atteint la 1ère place des tendances Hugging Face. Un tournant pour l''IA open source mondiale.'

'Guide Z-Image Turbo : Faire tourner le monstre 6B d''Alibaba dans ComfyUI (Vs. FLUX)'

'Oubliez les 24 Go de VRAM. Le Z-Image Turbo (6B) d''Alibaba offre des résultats photoréalistes et un rendu de texte chinois parfait en seulement 8 étapes. Voici votre guide complet du workflow ComfyUI.'

Test de Google Veo 3.1 : La révolution du 4K, du format vertical et de la cohérence vidéo

Google Veo 3.1 apporte l'upscaling 4K natif, la vidéo verticale 9:16 et la cohérence de l'identité. De plus, un aperçu du code du modèle Veo 3.2 qui a fuité.