'Briser le monopole de Nvidia : Comment GLM-Image et la puce Ascend de Huawei ont conquis les classements IA'

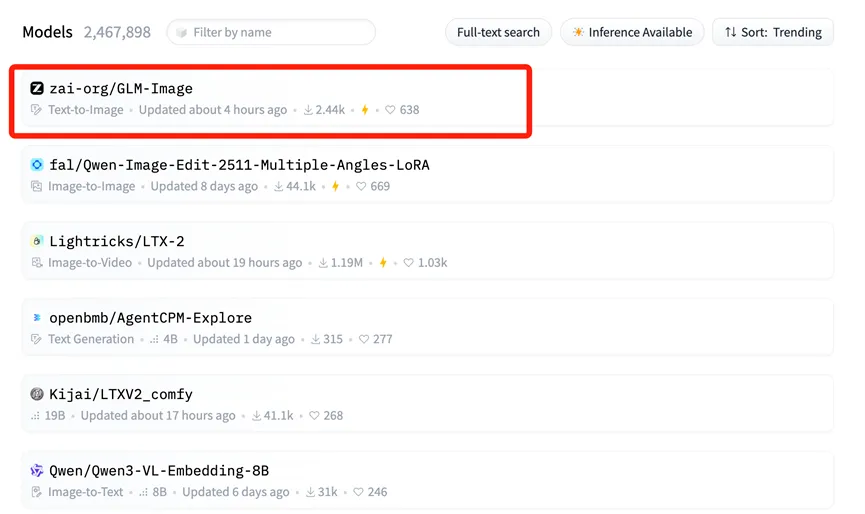

Le 14 janvier, un changement sismique s'est produit dans le paysage mondial de l'intelligence artificielle, attirant l'attention des acteurs industriels et des marchés financiers du monde entier. GLM-Image, un modèle de génération d'images multimodal développé conjointement par Zhipu AI et Huawei, s'est hissé à la première place de la liste Trending (tendances) de Hugging Face.

Pour les non-initiés, Hugging Face est essentiellement « l'Exposition Universelle » des modèles open source — un hub central où les géants internationaux et les développeurs présentent leurs meilleurs outils d'IA. Atteindre le sommet de sa liste Trending équivaut à occuper la scène principale de la plus grande conférence technologique mondiale, signifiant la reconnaissance internationale des prouesses techniques et de la valeur applicative de GLM-Image.

Le média américain CNBC a noté que ce modèle avancé, entraîné par Zhipu et Huawei, « brise efficacement le mythe » de la dépendance aux puces américaines. Cette réussite n'est pas accidentelle ; elle est le résultat inévitable d'une profonde « synergie logiciel-matériel » et d'une percée dans toute la chaîne industrielle nationale de l'IA en Chine.

La fondation « Full-Stack » : Huawei Ascend & MindSpore

Le soutien critique derrière cette réussite est la fondation de puissance de calcul nationale construite par Huawei.

Contrairement à la plupart des modèles d'IA précédents qui dépendaient fortement des GPU étrangers (principalement Nvidia) pour l'entraînement, GLM-Image a exécuté l'intégralité de son cycle de vie — du prétraitement des données à l'entraînement à grande échelle — sur les puces Huawei Ascend 800T A2 et le framework d'IA MindSpore.

Cette combinaison totalement autonome « matériel + framework » est la véritable information ici. Elle résout le problème central du « goulot d'étranglement » dans le développement de l'IA, prouvant que l'entraînement de modèles de pointe (SOTA) est possible sans dépendre de l'écosystème CUDA. La série Ascend 910B (qui propulse le 800T A2) a démontré des performances redoutables dans les environnements de grands clusters, offrant une alternative viable à la communauté open source mondiale.

Déconstruction de l'architecture : Pourquoi AR + Diffusion est important

Zhipu AI a également réalisé une innovation significative dans l'architecture du modèle. GLM-Image s'est écarté des voies techniques standard utilisées par de nombreux modèles open source occidentaux.

Au lieu de cela, il utilise une architecture hybride « Autorégressif (AR) + Décodeur de Diffusion ».

- Le « Cerveau » (Autorégressif) : Un modèle AR de 9 milliards (9B) de paramètres gère la compréhension des instructions complexes, la planification de la mise en page et la génération de texte dans les images.

- Le « Peintre » (Diffusion) : Un modèle de diffusion de 7 milliards (7B) de paramètres agit comme décodeur, remplissant des détails haute fidélité basés sur le plan du modèle AR.

Cette approche résout un problème notoire dans la génération d'images par IA : le rendu précis du texte. Auparavant, les images générées par IA présentaient souvent un texte brouillé et illisible. Grâce aux fortes capacités cognitives du composant AR, GLM-Image a atteint la plus haute précision dans la génération de caractères chinois parmi les modèles open source.

Cette voie technique — priorisant la compréhension cognitive avant la génération — reflète l'approche observée dans les modèles de raisonnement cognitif avancés comme Nano Banana Pro, qui se concentre sur « connaissance + raisonnement » pour gérer des tâches complexes avec une plus grande précision que les modèles génératifs standard.

Réaction du marché : L'ascension de Knowledge Atlas (2513.HK)

La valeur « étalon-or » d'être en tête du classement mondial s'est immédiatement reflétée dans les réactions du marché des capitaux. Lorsque la nouvelle de la mise en open source de GLM-Image a éclaté, le cours de l'action de l'entité mère de Zhipu AI, Knowledge Atlas (2513.HK), a bondi de plus de 16 % en une seule journée. Les investisseurs ont clairement reconnu la valeur à long terme de la combinaison « puce nationale + modèle autonome ».

En fait, depuis son introduction à la Bourse de Hong Kong le 8 janvier en tant que « première action mondiale de grand modèle », Knowledge Atlas a vu le prix de son action augmenter de plus de 100 %.

Démocratiser le design IA : L'Open Source pour tous

Dans une perspective à long terme, le succès de GLM-Image est porté par la synergie de toute une chaîne industrielle. Cette capacité de chaîne complète ne sert pas seulement les géants de la technologie ; elle abaisse considérablement les barrières pour les petites et moyennes entreprises (PME).

Avec des coûts d'inférence aussi bas que 0,1 RMB (env. 0,01 USD) par image, GLM-Image permet aux entreprises d'utiliser des outils de conception IA de premier plan à une fraction des coûts traditionnels.

Aujourd'hui, le code source et les poids de GLM-Image sont disponibles de manière synchrone sur GitHub et Hugging Face. Les développeurs du monde entier peuvent désormais utiliser librement cette « solution totalement autonome », brisant le récit traditionnel selon lequel l'entraînement de modèles de pointe dépend uniquement du silicium américain.

Kling 3.0 est sorti : Le guide ultime des fonctionnalités, prix et accès

Kling 3.0 est là ! Découvrez le nouveau moteur créatif intégré avec sortie 4K, Burst Mode de 15-second et effets visuels cinématographiques. Apprenez comment y accéder dès aujourd'hui.

J'ai testé Kling 3.0 Omni : Séquences de 15s, Audio Natif et la Vérité sur Gen-4.5

Kling 3.0 Omni est-il le tueur de Runway Gen-4.5 ? J'ai passé 24 heures à tester la génération native de 15 secondes, la précision du lip-sync et les contrôles multi-caméras. Voici le verdict.

Kimi k2.5 est sorti : Le partenaire ultime pour le workflow vidéo Kling 2.6

Kimi k2.5 est là avec une compréhension vidéo native et une fenêtre contextuelle de 256k. Apprenez comment le combiner avec Kling 2.6 pour automatiser votre pipeline de production vidéo IA.

Z-Image Base vs Turbo : Maîtriser le rendu de texte chinois dans les vidéos Kling 2.6

Apprenez à utiliser les modèles Z-Image Base et Turbo pour résoudre les problèmes de rendu de texte chinois dans les vidéos Kling 2.6. Guide complet du flux de travail pour les cas d'utilisation commerciaux et artistiques.

'Critique de Seedance 1.5 Pro : Le chef-d''œuvre audiovisuel de ByteDance avec un Lip-Sync parfait'

'Alors que LTX-2 a ouvert la porte, Seedance 1.5 Pro la perfectionne. Découvrez la génération audiovisuelle native, le lip-sync précis et le contrôle de caméra complexe en ligne.'

'Critique de LTX-2 (LTX Video) : Le premier modèle "Audio-Visuel" Open Source'

'Lightricks LTX-2 révolutionne la vidéo IA : 4K natif, 50 FPS, audio synchronisé, et tourne sur 16 Go de VRAM avec FP8. Essayez-le en ligne ou consultez le guide ComfyUI.'

'Guide Z-Image Turbo : Faire tourner le monstre 6B d''Alibaba dans ComfyUI (Vs. FLUX)'

'Oubliez les 24 Go de VRAM. Le Z-Image Turbo (6B) d''Alibaba offre des résultats photoréalistes et un rendu de texte chinois parfait en seulement 8 étapes. Voici votre guide complet du workflow ComfyUI.'

Test de Google Veo 3.1 : La révolution du 4K, du format vertical et de la cohérence vidéo

Google Veo 3.1 apporte l'upscaling 4K natif, la vidéo verticale 9:16 et la cohérence de l'identité. De plus, un aperçu du code du modèle Veo 3.2 qui a fuité.