'Seedance 1.5 Pro Review: ByteDances audiovisuelles Meisterwerk mit perfektem Lip-Sync'

Wenn 2025 mit der Open-Source-Revolution von LTX-2 endete, beginnt 2026 mit einer Demonstration roher industrieller Macht. Seedance 1.5 Pro, das neueste Foundation-Modell von ByteDance (dem Team hinter TikTok/Doubao), hat offiziell die Arena betreten.

Wie LTX-2 verfügt es über native audiovisuelle gemeinsame Generierung (Native Audio-Visual Joint Generation) – es erstellt Ton und Video in einem einzigen Durchgang. Aber Seedance 1.5 Pro geht noch einen Schritt weiter. Es zielt auf den „Heiligen Gral“ des KI-Videos ab: Charakterdialog und narrative Konsistenz.

Während Sie dies (noch) nicht auf Ihrer lokalen RTX 4090 ausführen können, verändern seine Fähigkeiten über die Volcano Engine API die Art und Weise, wie Werbespots und Kurzfilme erstellt werden. In diesem Review analysieren wir das Seedance 1.5 Arxiv-Papier (2512.13507) und vergleichen es direkt mit seinem Open-Source-Rivalen LTX-2.

Unter der Haube: Die „Dual-Branch“ DiT-Architektur

Im Gegensatz zu herkömmlichen Videomodellen, die Audio als nachträglichen Gedanken behandeln, basiert Seedance 1.5 Pro auf einem Dual-Branch Diffusion Transformer (DiT).

- Visueller Zweig: Behandelt Pixelgenerierung, Bewegungsdynamik und Beleuchtung.

- Audio-Zweig: Erzeugt Wellenformen, Hintergrundatmosphäre und Dialoge.

- Die Magie: Ein „Cross-Modal Joint Module“ verbindet diese beiden Zweige bei jedem Schritt des Diffusionsprozesses.

Warum das wichtig ist: Wenn ein Charakter in Seedance 1.5 Pro spricht, „matcht“ das Modell nicht einfach Lippenbewegungen mit einer vorab aufgezeichneten Spur. Es generiert die Form des Mundes und den Klang des Phonems gleichzeitig. Dies führt zu einer Seedance 1.5 Lip-Sync-Leistung, die mit manueller Animation konkurriert.

Killer-Feature 1: Präzisions-Lip-Sync & Dialekte

Hier wird Seedance 1.5 Pro vs. LTX-2 zu einem einseitigen Kampf. Während LTX-2 großartig für atmosphärische Klänge (Explosionen, Regen) ist, zeichnet sich Seedance durch menschliche Performance aus.

- Mehrsprachige Unterstützung: Native Unterstützung für Mandarin, Englisch, Japanisch und Koreanisch.

- Dialect-Beherrschung: Überraschenderweise unterstützt das Modell spezifische chinesische Dialekte (wie Sichuanesisch oder Kantonesisch) und bewahrt den kulturellen Rhythmus der Sprache.

- Anwendungsfall: Ideal für KI-Kurzdramen (Short Dramas) und globale E-Commerce-Anzeigen, bei denen Synchronisation normalerweise die Immersion bricht.

Hinweis: Das Modell kann einen Charakter generieren, der Zeilen aus einem Textskript mit perfekter Synchronisation spielt – eine Funktion, die jetzt vollständig auf unserer Plattform verfügbar ist.

Killer-Feature 2: Filmische Kamerasteuerung

Bewegungskontrolle war schon immer eine Schwäche generativer Videos. Seedance 1.5 Pro führt ein „Kamerasteuerungs-Interface“ ein, das kinematografische Terminologie versteht.

Sie können explizit komplexe Kamerabewegungen prompten:

- „Hitchcock Zoom“ (Dolly Zoom): Der Hintergrund wird komprimiert, während das Subjekt stationär bleibt.

- „Long Take Tracking“: Verfolgen eines Subjekts für 10+ Sekunden ohne Morphing.

- „Whip Pan“: Schneller Übergang zwischen zwei Subjekten.

Für Creator bedeutet dies, dass Seedance 1.5 Motion Control kein Zufall mehr ist – es ist ein steuerbares Werkzeug.

Vergleich: Seedance 1.5 Pro vs. LTX-2

| Feature | Seedance 1.5 Pro (ByteDance) | LTX-2 (Lightricks) |

|---|---|---|

| Architektur | Dual-Branch DiT (Geschlossen) | Single-Stream DiT (Offen) |

| Zugriff | Volcano Engine API | Lokal / ComfyUI |

| Lip-Sync | Perfekt (Dialog-Fokus) | Basis (Soundeffekt-Fokus) |

| Bewegung | Komplex (Kamerasteuerung) | Schnell & Flüssig |

| Kosten | Pro Token / API-Aufruf | Kostenlos (Hardwareabhängig) |

| Beste für | Storytelling & Werbung | Musikvideos & Social |

Integration: Zugriff auf Seedance 1.5 Pro

Da Seedance ein API-basiertes Modell ist, können Sie .safetensors im Allgemeinen nicht lokal wie bei LTX-2 laden.

Die Herausforderung mit lokalem ComfyUI

Obwohl einige Seedance 1.5 ComfyUI-Wrapper existieren, erfordern sie, dass Sie ein spezielles Unternehmenskonto bei ByteDances Volcano Engine beantragen und komplexe API-Schlüssel und Abrechnungen verwalten.

Die Lösung: Nutzen Sie unsere Integration

Wir haben die Seedance 1.5 Pro API direkt in unsere Website integriert und machen sie so für jeden ohne Unternehmenshürden zugänglich.

- Keine API-Schlüssel erforderlich: Wir kümmern uns um die Backend-Verbindung.

- Sofortiger Zugriff: Nutzen Sie die Lip-Sync- und Kamerasteuerungsfunktionen über unsere einfache Benutzeroberfläche.

- Kostengünstig: Generieren Sie Videos, ohne Cloud-Infrastruktur verwalten zu müssen.

Seedance 1.5 Pro online testen (Starten Sie mit der Erstellung professioneller KI-Videos).

Der „Motion Magnitude“ Parameter

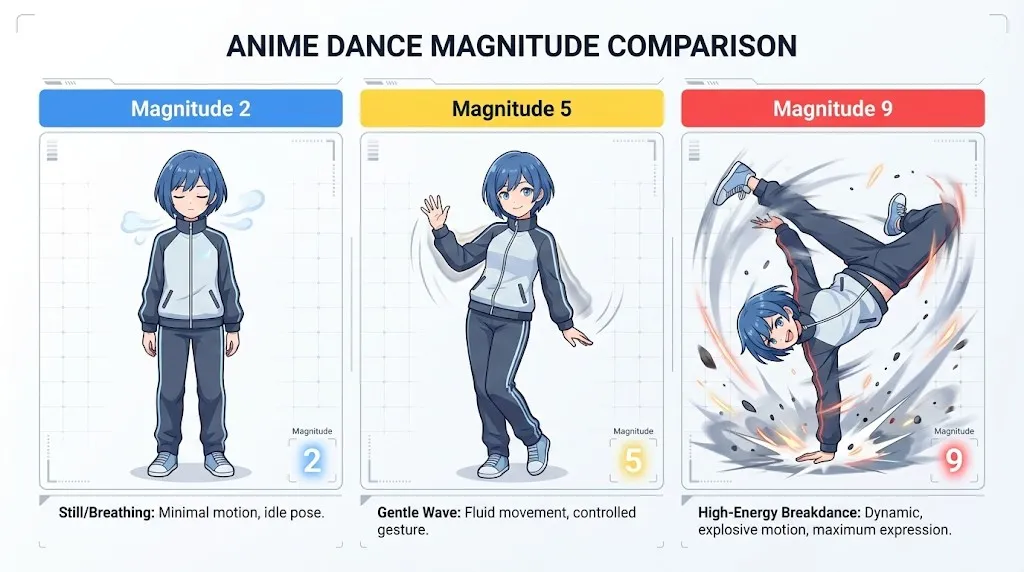

Ein technisches Detail aus dem Seedance 1.5 Arxiv-Papier, das erwähnenswert ist, ist die „Motion Magnitude“-Steuerung.

- Niedrig (1-3): Subtile Bewegungen, Mikroausdrücke (großartig für Interviews).

- Hoch (7-10): Übertriebene Anime-Style-Action oder Tanzbewegungen.

Wenn Sie Seedance 1.5 für Tanzgenerierung verwenden, drehen Sie diesen Parameter auf 8 hoch, um sicherzustellen, dass sich die Gliedmaßen flüssig bewegen, ohne in den Torso zu „kollabieren“.

Fazit

Seedance 1.5 Pro ist der „Erwachsene im Raum“ für KI-Video. Während Open-Source-Modelle wie LTX-2 Spaß machen und zugänglich sind, bietet Seedance die Konsistenz und Kontrolle, die für professionelle Produktionspipelines erforderlich sind.

Wenn Ihr Projekt sprechende Charaktere, komplexe narrative Kamerabewegungen beinhaltet oder strikte Einhaltung eines Skripts erfordert, ist Seedance 1.5 Pro derzeit konkurrenzlos. Es beweist, dass die Zukunft von KI-Video nicht nur aus Pixeln besteht – sondern aus der nahtlosen Hochzeit von Ton und Vision.

'LTX-2 (LTX Video) Review: Das erste Open-Source "Audio-Visual" Foundation Model'

'Lightricks LTX-2 revolutioniert KI-Video: Natives 4K, 50 FPS, synchronisierter Ton und läuft auf 16 GB VRAM mit FP8. Testen Sie es online oder lesen Sie den ComfyUI-Guide.'

Kling 3.0 Veröffentlicht: Der ultimative Guide zu Funktionen, Preisen und Zugang

Kling 3.0 ist da! Entdecken Sie die neue integrierte Kreativ-Engine mit 4K-Ausgabe, 15-second Burst Mode und filmischen visuellen Effekten. Erfahren Sie, wie Sie heute Zugang erhalten.

Ich habe Kling 3.0 Omni getestet: 15s Shots, natives Audio und die Wahrheit über Gen-4.5

Ist Kling 3.0 Omni der Runway Gen-4.5 Killer? Ich habe 24 Stunden damit verbracht, die native 15-Sekunden-Generierung, die Lippensynchronität und die Multi-Kamera-Steuerung zu testen. Hier ist das Urteil.

Kimi k2.5 ist da: Der perfekte Partner für den Kling 2.6 Workflow

Kimi k2.5 ist da – mit nativem Videoverständnis und einem 256k-Kontextfenster. Erfahren Sie, wie Sie es mit Kling 2.6 kombinieren, um Ihre KI-Videoproduktions-Pipeline zu automatisieren.

Z-Image Base vs. Turbo: Meisterung chinesischer Textdarstellung in Kling 2.6 Videos

Lernen Sie, wie Sie Z-Image Base und Turbo Modelle nutzen, um Probleme bei der Darstellung chinesischer Texte in Kling 2.6 Videos zu beheben. Vollständiger Workflow-Leitfaden für kommerzielle und künstlerische Anwendungsfälle.

'Das Ende des Nvidia-Monopols: Wie GLM-Image und Huawei Ascend die globalen AI-Charts eroberten'

'Am 14. Januar erreichte GLM-Image, das vollständig auf Huawei Ascend-Chips und dem MindSpore-Framework trainiert wurde, Platz 1 der Hugging Face Trends. Ein Wendepunkt für globale Open-Source-KI.'

'Z-Image Turbo Guide: Alibabas 6B-Monster in ComfyUI ausführen (Vs. FLUX)'

'Vergessen Sie 24 GB VRAM. Alibabas Z-Image Turbo (6B) liefert fotorealistische Ergebnisse und perfektes chinesisches Text-Rendering in nur 8 Schritten. Hier ist Ihr kompletter ComfyUI-Workflow-Guide.'

Google Veo 3.1 im Test: Die Revolution für 4K, Hochformat und Videokonsistenz

Google Veo 3.1 bringt natives 4K-Upscaling, 9:16-Vertikalvideos und Identitätskonsistenz. Plus: Ein Blick auf den geleakten Veo 3.2 Modell-Code.