'Das Ende des Nvidia-Monopols: Wie GLM-Image und Huawei Ascend die globalen AI-Charts eroberten'

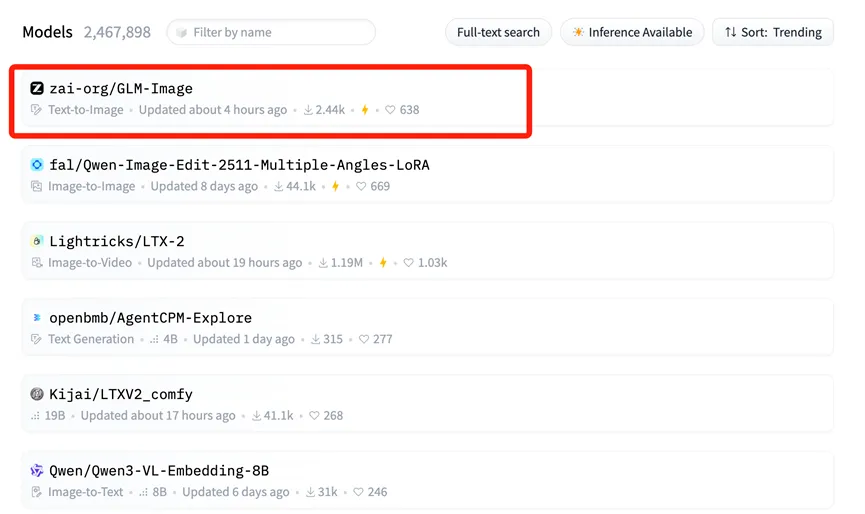

Am 14. Januar ereignete sich eine seismische Verschiebung in der globalen KI-Landschaft, die sowohl Industriegenies als auch die Kapitalmärkte weltweit aufhorchen ließ. GLM-Image, ein multimodales Bildgenerierungsmodell, das gemeinsam von Zhipu AI und Huawei entwickelt wurde, kletterte auf Platz eins der Hugging Face Trending-Liste.

Für Uneingeweihte: Hugging Face ist im Grunde die „Weltausstellung“ für Open-Source-Modelle – ein zentraler Hub, an dem internationale Giganten und Entwickler ihre besten KI-Tools präsentieren. Die Spitze der Trending-Liste zu erreichen, ist vergleichbar mit dem Hauptauftritt auf der weltweit wichtigsten Tech-Konferenz und signalisiert die internationale Anerkennung der technischen Leistungsfähigkeit und des Anwendungswerts von GLM-Image.

Der US-Nachrichtensender CNBC bemerkte, dass dieses fortschrittliche Modell, trainiert von Zhipu und Huawei, den „Mythos“ der Abhängigkeit von US-Chips wirkungsvoll „bricht“. Dieser Erfolg ist kein Zufall, sondern das unvermeidliche Ergebnis einer tiefen „Software-Hardware-Synergie“ und eines Durchbruchs in der gesamten heimischen KI-Industriekette Chinas.

Das „Full-Stack“-Fundament: Huawei Ascend & MindSpore

Die entscheidende Stütze hinter diesem Erfolg ist das von Huawei aufgebaute Rechenleistungsfundament.

Im Gegensatz zu den meisten früheren KI-Modellen, die für das Training stark auf ausländische GPUs (hauptsächlich Nvidia) angewiesen waren, lief GLM-Image über seinen gesamten Lebenszyklus – von der Datenvorverarbeitung bis zum massiven Training – auf Huawei Ascend 800T A2 Chips und dem MindSpore KI-Framework.

Diese vollständig autonome „Hardware + Framework“-Kombination ist die eigentliche Sensation. Sie löst das zentrale „Nadelöhr“-Problem in der KI-Entwicklung und beweist, dass das Training von State-of-the-Art (SOTA) Modellen auch ohne das CUDA-Ökosystem möglich ist. Die Ascend 910B-Serie (die den 800T A2 antreibt) hat eine beeindruckende Leistung in großen Cluster-Umgebungen gezeigt und bietet der globalen Open-Source-Community eine echte Alternative.

Die Architektur dekonstruiert: Warum AR + Diffusion zählt

Zhipu AI erzielte auch bei der Modellarchitektur bedeutende Innovationen. GLM-Image wich von den technischen Standardrouten ab, die von vielen westlichen Open-Source-Modellen verwendet werden.

Stattdessen nutzt es eine hybride „Autoregressive (AR) + Diffusion Decoder“ Architektur.

- Das „Gehirn“ (Autoregressiv): Ein 9B-Parameter-AR-Modell kümmert sich um das Verständnis komplexer Anweisungen, die Layout-Planung und die Textgenerierung innerhalb von Bildern.

- Der „Maler“ (Diffusion): Ein 7B-Parameter-Diffusionsmodell fungiert als Decoder und füllt basierend auf dem Bauplan des AR-Modells hochauflösende Details ein.

Dieser Ansatz löst ein berüchtigtes Problem bei der KI-Bildgenerierung: die präzise Darstellung von Text. Zuvor enthielten KI-generierte Bilder oft verstümmelten, unleserlichen Text. Dank der starken kognitiven Fähigkeiten der AR-Komponente erzielte GLM-Image die höchste Genauigkeit bei der Generierung chinesischer Schriftzeichen unter allen Open-Source-Modellen.

Dieser technische Pfad – kognitives Verstehen vor der Generierung zu priorisieren – spiegelt den Ansatz wider, der in fortschrittlichen kognitiven Reasoning-Modellen wie Nano Banana Pro zu sehen ist, die sich auf „Wissen + Logik“ konzentrieren, um komplexe Aufgaben präziser zu bewältigen als Standard-Generierungsmodelle.

Marktreaktion: Der Aufstieg von Knowledge Atlas (2513.HK)

Der „Goldstandard“-Wert, die globalen Charts anzuführen, spiegelte sich sofort in den Reaktionen des Kapitalmarktes wider. Als die Nachricht von der Open-Source-Veröffentlichung von GLM-Image bekannt wurde, stieg der Aktienkurs von Zhipu AIs Muttergesellschaft, Knowledge Atlas (2513.HK), an einem einzigen Tag um über 16 %. Investoren erkannten klar den langfristigen Wert der Kombination aus „heimischem Chip + autonomem Modell“.

Tatsächlich ist der Aktienkurs von Knowledge Atlas seit der Notierung an der Hongkonger Börse am 8. Januar als „erste globale Large-Model-Aktie“ um über 100 % gestiegen.

Demokratisierung von AI-Design: Open Source für alle

Langfristig betrachtet wird der Erfolg von GLM-Image durch die Synergie einer ganzen Industriekette vorangetrieben. Diese Full-Chain-Fähigkeit dient nicht nur Tech-Giganten, sondern senkt die Barrieren für kleine und mittlere Unternehmen (KMU) erheblich.

Mit Inferenzkosten von nur 0,1 RMB (ca. 0,01 USD) pro Bild ermöglicht GLM-Image Unternehmen die Nutzung erstklassiger KI-Designtools zu einem Bruchteil der herkömmlichen Kosten.

Heute sind der Quellcode und die Gewichte für GLM-Image synchron auf GitHub und Hugging Face verfügbar. Entwickler weltweit können nun diese „vollständig autonome Lösung“ frei nutzen und damit das traditionelle Narrativ durchbrechen, dass Spitzentraining von Modellen ausschließlich von US-Silizium abhängt.

Kling 3.0 Veröffentlicht: Der ultimative Guide zu Funktionen, Preisen und Zugang

Kling 3.0 ist da! Entdecken Sie die neue integrierte Kreativ-Engine mit 4K-Ausgabe, 15-second Burst Mode und filmischen visuellen Effekten. Erfahren Sie, wie Sie heute Zugang erhalten.

Ich habe Kling 3.0 Omni getestet: 15s Shots, natives Audio und die Wahrheit über Gen-4.5

Ist Kling 3.0 Omni der Runway Gen-4.5 Killer? Ich habe 24 Stunden damit verbracht, die native 15-Sekunden-Generierung, die Lippensynchronität und die Multi-Kamera-Steuerung zu testen. Hier ist das Urteil.

Kimi k2.5 ist da: Der perfekte Partner für den Kling 2.6 Workflow

Kimi k2.5 ist da – mit nativem Videoverständnis und einem 256k-Kontextfenster. Erfahren Sie, wie Sie es mit Kling 2.6 kombinieren, um Ihre KI-Videoproduktions-Pipeline zu automatisieren.

Z-Image Base vs. Turbo: Meisterung chinesischer Textdarstellung in Kling 2.6 Videos

Lernen Sie, wie Sie Z-Image Base und Turbo Modelle nutzen, um Probleme bei der Darstellung chinesischer Texte in Kling 2.6 Videos zu beheben. Vollständiger Workflow-Leitfaden für kommerzielle und künstlerische Anwendungsfälle.

'Seedance 1.5 Pro Review: ByteDances audiovisuelles Meisterwerk mit perfektem Lip-Sync'

'Während LTX-2 die Tür öffnete, perfektioniert Seedance 1.5 Pro sie. Erleben Sie native audiovisuelle Generierung, präzisen Lip-Sync und komplexe Kamerasteuerung jetzt online.'

'LTX-2 (LTX Video) Review: Das erste Open-Source "Audio-Visual" Foundation Model'

'Lightricks LTX-2 revolutioniert KI-Video: Natives 4K, 50 FPS, synchronisierter Ton und läuft auf 16 GB VRAM mit FP8. Testen Sie es online oder lesen Sie den ComfyUI-Guide.'

'Z-Image Turbo Guide: Alibabas 6B-Monster in ComfyUI ausführen (Vs. FLUX)'

'Vergessen Sie 24 GB VRAM. Alibabas Z-Image Turbo (6B) liefert fotorealistische Ergebnisse und perfektes chinesisches Text-Rendering in nur 8 Schritten. Hier ist Ihr kompletter ComfyUI-Workflow-Guide.'

Google Veo 3.1 im Test: Die Revolution für 4K, Hochformat und Videokonsistenz

Google Veo 3.1 bringt natives 4K-Upscaling, 9:16-Vertikalvideos und Identitätskonsistenz. Plus: Ein Blick auf den geleakten Veo 3.2 Modell-Code.