'LTX-2 (LTX Video) Review: Das erste Open-Source "Audio-Visual" Foundation Model'

Gerade als wir dachten, der KI-Videokrieg zwischen Hunyuan und Wan 2.1 würde sich beruhigen, ließ Lightricks eine Bombe platzen. LTX-2 (früher bekannt als LTX Video) wurde offiziell mit offenen Gewichten (Open Weights) veröffentlicht, und es ist nicht einfach nur ein weiterer Videogenerator.

Es ist das weltweit erste Open-Weight-Foundation-Modell, das zu gemeinsamer audiovisueller Generierung (Joint Audiovisual Generation) fähig ist – das bedeutet, es erstellt Video und synchronisierten Ton gleichzeitig in einem einzigen Durchgang.

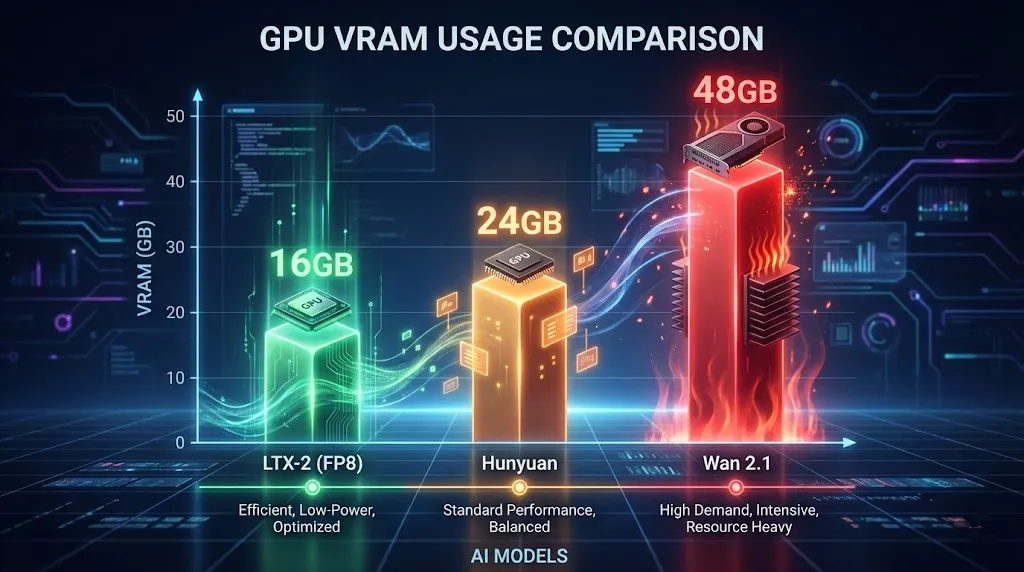

Aber die eigentliche Schlagzeile für lokale Nutzer? Effizienz. Im Gegensatz zum VRAM-hungrigen Hunyuan Video läuft LTX-2 bequem auf 16 GB Consumer-GPUs (unter Verwendung von NVFP8-Quantisierung) und liefert nahezu Echtzeit-Generierungsgeschwindigkeiten, die andere Modelle so wirken lassen, als würden sie in Zeitlupe rendern.

Wenn Sie nach einem Open-Source-KI-Videogenerator im Jahr 2026 suchen, der Ton erzeugt und Ihre GPU nicht zum Schmelzen bringt, dann ist dies der richtige. In diesem Leitfaden tauchen wir tief in die Spezifikationen ein, vergleichen LTX-2 vs. Hunyuan Video und zeigen Ihnen, wie Sie es sofort nutzen können.

Die Innovation: Gemeinsame Audio-Video-Generierung

Lightricks hat ein massives Problem gelöst: Sounddesign. Basierend auf einer neuartigen DiT (Diffusion Transformer) Architektur versteht LTX-2 den Zusammenhang zwischen Bewegung und Ton.

- Wie es funktioniert: Wenn Sie als Prompt „ein zerbrechendes Glas“ eingeben, generiert das Modell sofort die visuell fliegenden Scherben und das synchronisierte Geräusch des brechenden Glases.

- Warum es wichtig ist: Kein Suchen mehr nach Stock-Soundeffekten oder mühsames Synchronisieren von Audio in der Postproduktion. Alles wird nativ generiert.

Wichtige Spezifikationen

- Auflösung: Native 4K-Unterstützung (Optimiert für 720p auf lokalen GPUs).

- Bildrate: Bis zu 50 FPS für flüssige Bewegungen (Standard ist 24 FPS).

- Audio: Native synchronisierte Audioerzeugung (48kHz Stereo).

- Lizenz: Kostenlos für kommerzielle Nutzung (für Unternehmen mit <10 Mio. $ Jahresumsatz).

Hardware-Anforderungen: Können Sie es ausführen?

Hier glänzt LTX-2. Während Run LTX Video locally 24GB VRAM ideal für 4K ist, passt das Modell dank NVFP8-Quantisierung auf Mittelklasse-Karten.

Mindestanforderungen für 720p (4 Sekunden)

- GPU: NVIDIA RTX 3080 / 4070 Ti / 4080 (12 GB - 16 GB VRAM).

- RAM: 32 GB System-RAM.

- Speicher: 50 GB SSD-Speicherplatz.

Für diejenigen, die fragen: „Run LTX Video locally 16GB VRAM“ – Ja, absolut. Indem Sie den FP8-Text-Encoder und die Modellgewichte in ComfyUI aktivieren, können Sie 720p / 24fps / 4s-Clips generieren, ohne auf OOM-Fehler (Out of Memory) zu stoßen.

LTX-2 vs. Hunyuan Video: Das Duell

Wir haben beide Modelle ausgiebig getestet. Hier ist das Urteil für 2026.

| Feature | LTX-2 (Lightricks) | Hunyuan Video | Wan 2.1 |

|---|---|---|---|

| Audio | Native Sync (Sieger) | Nein | Nein |

| Geschwindigkeit | Schnell (FP8) | Mittel | Langsam (Hohe Qualität) |

| VRAM | 16 GB Freundlich | 24 GB+ Empfohlen | 48 GB+ (Enterprise) |

| Kohärenz | Gut (Kurze Clips) | Exzellent | Klassenbester |

| Lizenz | Community (<$10M) | Open Source | Open Source |

Urteil: Wählen Sie LTX-2 für Social-Media-Inhalte, Musikvisualisierungen und Szenarien, in denen Ton entscheidend ist. Wählen Sie Hunyuan oder Wan 2.1, wenn Sie visuelle Kohärenz auf Hollywood-Niveau benötigen und Audio egal ist.

Tutorial: So verwenden Sie LTX-2 (Online vs. Lokal)

Sie haben zwei Möglichkeiten, dieses Modell auszuführen.

Option 1: Der einfachste Weg (Empfohlen)

Sie benötigen keine 2000-Dollar-GPU, um LTX-2 zu verwenden. Wir haben das vollständige Modell direkt in unsere Plattform integriert.

- Keine Installation erforderlich.

- Schnelle Generierung in unserer Cloud.

- Sofortige audiovisuelle Vorschau.

LTX-2 jetzt online testen (Klicken, um zu generieren).

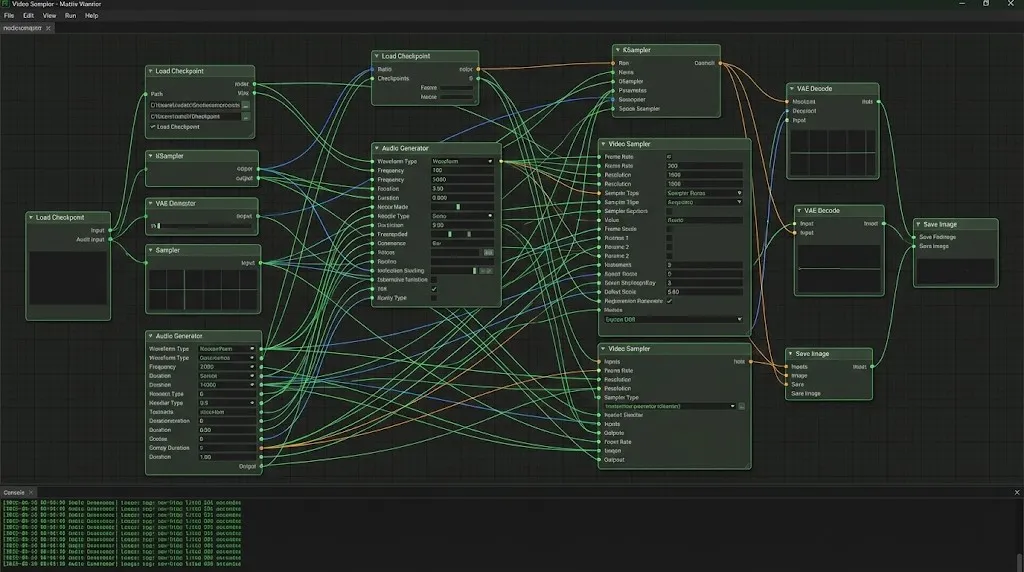

Option 2: Lokales ComfyUI-Setup (Für Entwickler)

Wenn Sie es lieber lokal ausführen möchten, folgen Sie diesen Schritten:

- Custom Nodes installieren: Suchen Sie im Manager nach

ComfyUI-LTXVideo. - Gewichte herunterladen: Holen Sie sich

ltx-video-2b-v0.9.safetensors(FP8-Version) von Hugging Face. - Workflow laden: Erstellen Sie einen Standard-Workflow, der den LTX Loader mit dem Sampler verbindet.

- Prompten: Setzen Sie Frames auf 97 (ca. 4 Sekunden) und genießen Sie es.

Pro-Tipp: Das lokale Setup erfordert oft Fehlerbehebung bei Python-Abhängigkeiten. Wenn Fehler auftreten, empfehlen wir den Wechsel zu unserem Online-Tool für ein problemloses Erlebnis.

LTX-2 Prompt Engineering Tipps

Gute Ergebnisse erfordern spezifische Prompt-Strategien. LTX-2 versteht sowohl visuelle als auch auditive Hinweise.

1. Audiovisuelle Prompts

Beschreiben Sie den Ton innerhalb Ihres visuellen Prompts:

- Prompt: "A cinematic shot of a thunderstorm, lightning strikes a tree, loud thunder crack, rain pouring sound."

- Ergebnis: Das Modell synchronisiert den Lichtblitz mit dem Audio-Peak des Donners.

2. Kamerasteuerung

Verwenden Sie diese, um die Aufnahme zu lenken:

LTX Video camera control prompts: "Camera pan right", "Slow zoom in", "Drone shot", "Low angle".- Beispiel: "Cinematic drone shot flying over a cyberpunk city, neon lights, fog, 4k, highly detailed, electronic synthesizer music background."

3. Die Negative Prompt Liste

Um den bei schnellen Modellen üblichen „schmelzenden Gesichts“-Effekt zu vermeiden, verwenden Sie diese LTX Video negative prompts list:

"Blurry, distorted, morphing, jittery, watermarks, text, bad anatomy, static, frozen, silence, muted."

FAQ: Fehlerbehebung & Optimierung

F: Meine lokale Generierung ist nur ein schwarzer Bildschirm.

A: Dies passiert normalerweise, wenn Sie den falschen VAE-Dtype verwenden. Stellen Sie sicher, dass Ihr VAE auf bfloat16 eingestellt ist, wenn Ihre GPU dies unterstützt, oder auf float32, wenn Sie ältere Karten haben.

F: LTX-2 Einstellungen auf 720p bringen meinen PC zum Absturz.

A: Aktivieren Sie --lowvram in Ihrer ComfyUI-Bat-Datei. Stellen Sie außerdem sicher, dass Ihr „Frame Count“ der Formel (8 * n) + 1 folgt (z. B. 97, 121) für eine optimale Tensor-Ausrichtung.

F: Kann ich das kommerziell nutzen? A: Ja! Wenn Ihr Jahresumsatz unter 10 Millionen USD liegt, erlaubt die LTX-2 Community License die volle kommerzielle Nutzung.

Fazit

Lightricks LTX-2 ist ein entscheidender Moment für Open-Source-KI. Es ist das erste Mal, dass wir ein Modell haben, das Geschwindigkeit, Audio und Zugänglichkeit in einem Paket vereint.

Auch wenn es Wan 2.1 in Bezug auf pixelgenaue Kohärenz vielleicht nicht schlägt, ist die Fähigkeit, synchronisierte audiovisuelle Clips zu generieren, revolutionär. Für die meisten Creator ist LTX-2 das Werkzeug, das endlich Ton in die KI-Video-Party bringt.

'Seedance 1.5 Pro Review: ByteDances audiovisuelles Meisterwerk mit perfektem Lip-Sync'

'Während LTX-2 die Tür öffnete, perfektioniert Seedance 1.5 Pro sie. Erleben Sie native audiovisuelle Generierung, präzisen Lip-Sync und komplexe Kamerasteuerung jetzt online.'

Kling 3.0 Veröffentlicht: Der ultimative Guide zu Funktionen, Preisen und Zugang

Kling 3.0 ist da! Entdecken Sie die neue integrierte Kreativ-Engine mit 4K-Ausgabe, 15-second Burst Mode und filmischen visuellen Effekten. Erfahren Sie, wie Sie heute Zugang erhalten.

Ich habe Kling 3.0 Omni getestet: 15s Shots, natives Audio und die Wahrheit über Gen-4.5

Ist Kling 3.0 Omni der Runway Gen-4.5 Killer? Ich habe 24 Stunden damit verbracht, die native 15-Sekunden-Generierung, die Lippensynchronität und die Multi-Kamera-Steuerung zu testen. Hier ist das Urteil.

Kimi k2.5 ist da: Der perfekte Partner für den Kling 2.6 Workflow

Kimi k2.5 ist da – mit nativem Videoverständnis und einem 256k-Kontextfenster. Erfahren Sie, wie Sie es mit Kling 2.6 kombinieren, um Ihre KI-Videoproduktions-Pipeline zu automatisieren.

Z-Image Base vs. Turbo: Meisterung chinesischer Textdarstellung in Kling 2.6 Videos

Lernen Sie, wie Sie Z-Image Base und Turbo Modelle nutzen, um Probleme bei der Darstellung chinesischer Texte in Kling 2.6 Videos zu beheben. Vollständiger Workflow-Leitfaden für kommerzielle und künstlerische Anwendungsfälle.

'Das Ende des Nvidia-Monopols: Wie GLM-Image und Huawei Ascend die globalen AI-Charts eroberten'

'Am 14. Januar erreichte GLM-Image, das vollständig auf Huawei Ascend-Chips und dem MindSpore-Framework trainiert wurde, Platz 1 der Hugging Face Trends. Ein Wendepunkt für globale Open-Source-KI.'

'Z-Image Turbo Guide: Alibabas 6B-Monster in ComfyUI ausführen (Vs. FLUX)'

'Vergessen Sie 24 GB VRAM. Alibabas Z-Image Turbo (6B) liefert fotorealistische Ergebnisse und perfektes chinesisches Text-Rendering in nur 8 Schritten. Hier ist Ihr kompletter ComfyUI-Workflow-Guide.'

Google Veo 3.1 im Test: Die Revolution für 4K, Hochformat und Videokonsistenz

Google Veo 3.1 bringt natives 4K-Upscaling, 9:16-Vertikalvideos und Identitätskonsistenz. Plus: Ein Blick auf den geleakten Veo 3.2 Modell-Code.