'Конец монополии Nvidia: Как GLM-Image и чип Huawei Ascend возглавили мировые рейтинги ИИ'

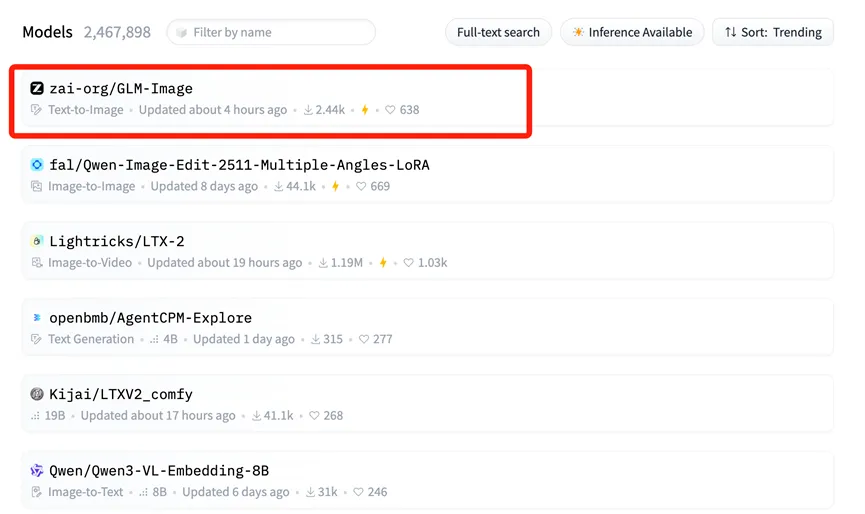

14 января в мировом ландшафте искусственного интеллекта произошел тектонический сдвиг, привлекший внимание как промышленных игроков, так и рынков капитала по всему миру. GLM-Image, мультимодальная модель генерации изображений, совместно разработанная Zhipu AI и Huawei, заняла первое место в списке трендов (Trending) Hugging Face.

Для непосвященных, Hugging Face — это по сути «Всемирная выставка» моделей с открытым исходным кодом, центральный хаб, где международные гиганты и разработчики демонстрируют свои лучшие ИИ-инструменты. Попадание на вершину списка трендов сродни выходу на главную сцену ведущей мировой технологической конференции, что означает международное признание технического мастерства и прикладной ценности GLM-Image.

Американское СМИ CNBC отметило, что эта передовая модель, обученная Zhipu и Huawei, эффективно «разрушает миф» о зависимости от американских чипов. Это достижение не случайно; это неизбежный результат глубокой «синергии программного и аппаратного обеспечения» и прорыва во всей внутренней цепочке ИИ-индустрии Китая.

Фундамент «Full-Stack»: Huawei Ascend и MindSpore

Ключевой опорой этого достижения является отечественная база вычислительных мощностей, построенная Huawei.

В отличие от большинства предыдущих моделей ИИ, которые для обучения в значительной степени полагались на зарубежные GPU (в основном Nvidia), GLM-Image прошла весь свой жизненный цикл — от предварительной обработки данных до масштабного обучения — на чипах Huawei Ascend 800T A2 и ИИ-фреймворке MindSpore.

Эта полностью автономная комбинация «железо + фреймворк» и есть главная новость. Она решает основную проблему «узкого горлышка» в развитии ИИ, доказывая, что обучение передовых моделей (SOTA) возможно без зависимости от экосистемы CUDA. Серия Ascend 910B (на которой работает 800T A2) продемонстрировала внушительную производительность в крупных кластерных средах, предлагая жизнеспособную альтернативу для глобального сообщества Open Source.

Разбор архитектуры: Почему AR + Diffusion это важно

Zhipu AI также добилась значительных инноваций в архитектуре модели. GLM-Image отошла от стандартных технических маршрутов, используемых многими западными моделями с открытым исходным кодом.

Вместо этого она использует гибридную архитектуру «Авторегрессия (AR) + Диффузионный декодер».

- «Мозг» (Авторегрессия): AR-модель с 9 миллиардами (9B) параметров отвечает за понимание сложных инструкций, планирование макета и генерацию текста внутри изображений.

- «Художник» (Диффузия): Диффузионная модель с 7 миллиардами (7B) параметров выступает в роли декодера, заполняя детали высокой четкости на основе чертежа AR-модели.

Этот подход решает печально известную проблему в генерации изображений ИИ: точный рендеринг текста. Ранее изображения, созданные ИИ, часто содержали искаженный, нечитаемый текст. Благодаря сильным когнитивным способностям компонента AR, GLM-Image достигла самой высокой точности в генерации китайских иероглифов среди моделей с открытым исходным кодом.

Этот технический путь — приоритизация когнитивного понимания перед генерацией — зеркально отражает подход, наблюдаемый в передовых моделях когнитивного мышления, таких как Nano Banana Pro, которые фокусируются на «знаниях + рассуждениях» для выполнения сложных задач с большей точностью, чем стандартные генеративные модели.

Реакция рынка: Взлет Knowledge Atlas (2513.HK)

Ценность «золотого стандарта» лидерства в мировом чарте немедленно отразилась на реакции рынка капитала. Когда появилась новость об открытии исходного кода GLM-Image, цена акций материнской компании Zhipu AI, Knowledge Atlas (2513.HK), взлетела более чем на 16% за один день. Инвесторы четко осознали долгосрочную ценность комбинации «отечественный чип + автономная модель».

Фактически, с момента листинга на Гонконгской фондовой бирже 8 января в качестве «первой глобальной акции больших моделей», цена акций Knowledge Atlas выросла более чем на 100%.

Демократизация ИИ-дизайна: Open Source для всех

В долгосрочной перспективе успех GLM-Image обусловлен синергией всей производственной цепочки. Эта возможность полной цепочки служит не только технологическим гигантам; она значительно снижает барьеры для малого и среднего бизнеса (SME).

При стоимости инференса всего 0,1 юаня (около 0,01 доллара США) за изображение, GLM-Image позволяет компаниям использовать инструменты ИИ-дизайна высшего уровня за долю от традиционных затрат.

Сегодня исходный код и веса для GLM-Image доступны синхронно на GitHub и Hugging Face. Разработчики по всему миру теперь могут свободно использовать это «полностью автономное решение», ломая традиционный нарратив о том, что обучение передовых моделей зависит исключительно от американского кремния.

Kling 3.0 Официально Выпущен: Полный Гид по Функциям, Ценам и Доступу

Kling 3.0 уже здесь! Откройте для себя новый интегрированный креативный движок с поддержкой 4K, 15-second Burst Mode и кинематографическими визуальными эффектами. Узнайте, как получить доступ уже сегодня.

Я протестировал Kling 3.0 Omni: 15-секундные кадры, нативный звук и правда о Gen-4.5

Станет ли Kling 3.0 Omni убийцей Runway Gen-4.5? Я потратил 24 часа на тестирование нативной 15-секундной генерации, точности липсинка и управления мультикамерой. Вот вердикт.

Вышел Kimi k2.5: Идеальный партнер для Kling 2.6

Kimi k2.5 уже здесь с нативным пониманием видео и контекстным окном 256k. Узнайте, как объединить его с Kling 2.6 для автоматизации вашего пайплайна создания видео с ИИ.

Z-Image Base vs Turbo: Освоение рендеринга китайского текста в видео Kling 2.6

Узнайте, как использовать модели Z-Image Base и Turbo для решения проблем с рендерингом китайского текста в видео Kling 2.6. Полное руководство по рабочему процессу для коммерческих и художественных задач.

'Обзор Seedance 1.5 Pro: Аудиовизуальный шедевр от ByteDance с идеальным липсинк'

'Пока LTX-2 открывал дверь, Seedance 1.5 Pro довел технологию до совершенства. Испытайте нативную аудиовизуальную генерацию, точный липсинк и сложное управление камерой онлайн.'

'Обзор LTX-2 (LTX Video): Первая Open Source "Аудио-Визуальная" модель'

'Lightricks LTX-2 революционизирует ИИ-видео: нативное 4K, 50 FPS, синхронизированный звук и работа на 16 ГБ VRAM с FP8. Попробуйте онлайн или изучите гайд по ComfyUI.'

'Гайд по Z-Image Turbo: Запуск 6B-монстра от Alibaba в ComfyUI (Vs. FLUX)'

'Забудьте о 24 ГБ VRAM. Z-Image Turbo (6B) от Alibaba выдает фотореалистичные результаты и идеальный рендеринг китайского текста всего за 8 шагов. Вот ваш полный гайд по рабочему процессу ComfyUI.'

Обзор Google Veo 3.1: Революция 4K, вертикального видео и консистентности

Google Veo 3.1 предлагает нативный апскейлинг до 4K, вертикальное видео 9:16 и консистентность идентификации. Плюс обзор утекшего кода модели Veo 3.2.