'Recensione LTX-2 (LTX Video): Il primo modello "Audio-Visivo" Open Source'

Proprio quando pensavamo che la guerra dei video AI si stesse calmando tra Hunyuan e Wan 2.1, Lightricks ha sganciato una bomba. LTX-2 (precedentemente noto come LTX Video) è stato ufficialmente rilasciato con pesi aperti (open weights), e non è solo un altro generatore di video.

È il primo modello di fondazione a pesi aperti al mondo capace di generazione audiovisiva congiunta — il che significa che crea video e audio sincronizzato simultaneamente in un unico passaggio.

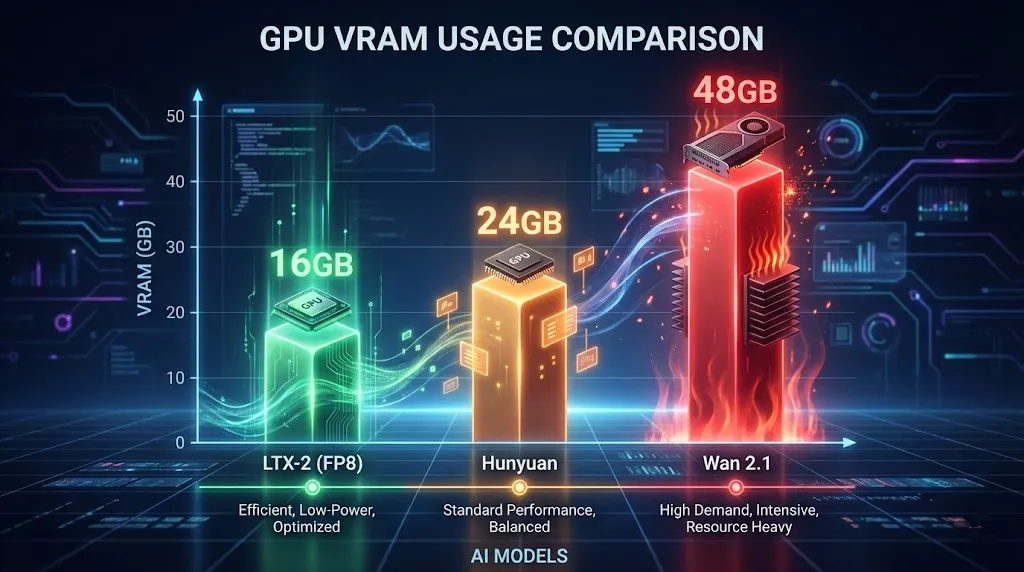

Ma la vera notizia per gli utenti locali? Efficienza. A differenza di Hunyuan Video affamato di VRAM, LTX-2 gira comodamente su GPU consumer da 16GB (usando la quantizzazione NVFP8), offrendo velocità di generazione quasi in tempo reale che fanno sembrare che altri modelli stiano renderizzando al rallentatore.

Se stai cercando un generatore di video AI open source nel 2026 che generi suoni e non fonda la tua GPU, questo è quello giusto. In questa guida, approfondiremo le specifiche, confronteremo LTX-2 vs Hunyuan Video, e ti mostreremo come usarlo immediatamente.

L'Innovazione: Generazione Congiunta Audio-Video

Lightricks ha risolto un enorme punto dolente: il sound design. Costruito su una nuova architettura DiT (Diffusion Transformer), LTX-2 comprende la correlazione tra movimento e suono.

- Come funziona: Quando inserisci il prompt "un bicchiere che si frantuma", il modello genera istantaneamente i frammenti che volano visivamente e il suono sincronizzato del vetro che si rompe.

- Perché è importante: Niente più ricerche di effetti sonori stock o tentativi di sincronizzare laboriosamente l'audio in post-produzione. Tutto è generato nativamente.

Specifiche Chiave

- Risoluzione: Supporto 4K nativo (Ottimizzato per 720p su GPU locali).

- Frame Rate: Fino a 50 FPS per movimenti fluidi (lo standard è 24 FPS).

- Audio: Generazione audio sincronizzata nativa (stereo 48kHz).

- Licenza: Gratuito per uso commerciale (per entità con <$10M di entrate annuali).

Requisiti Hardware: Puoi farlo girare?

È qui che brilla LTX-2. Mentre Run LTX Video locally 24GB VRAM è l'ideale per il 4K, il modello utilizza la quantizzazione NVFP8 per adattarsi alle schede di fascia media.

Specifiche Minime per 720p (4 Secondi)

- GPU: NVIDIA RTX 3080 / 4070 Ti / 4080 (12GB - 16GB VRAM).

- RAM: 32GB RAM di sistema.

- Archiviazione: 50GB di spazio SSD.

Per coloro che chiedono, "Run LTX Video locally 16GB VRAM" — Sì, assolutamente. Abilitando l'encoder di testo FP8 e i pesi del modello in ComfyUI, puoi generare clip 720p / 24fps / 4s senza incontrare errori OOM (Out of Memory).

LTX-2 vs Hunyuan Video: La Resa dei Conti

Abbiamo testato entrambi i modelli estensivamente. Ecco il verdetto per il 2026.

| Caratteristica | LTX-2 (Lightricks) | Hunyuan Video | Wan 2.1 |

|---|---|---|---|

| Audio | Sincronia Nativa (Vincitore) | No | No |

| Velocità | Veloce (FP8) | Moderata | Lento (Alta Qualità) |

| VRAM | Amichevole con 16GB | 24GB+ Raccomandato | 48GB+ (Enterprise) |

| Coerenza | Buona (Clip brevi) | Eccellente | Migliore della categoria |

| Licenza | Community (<$10M) | Open Source | Open Source |

Verdetto: Scegli LTX-2 per contenuti social media, visualizzatori musicali e scenari in cui il suono è cruciale. Scegli Hunyuan o Wan 2.1 se hai bisogno di coerenza visiva a livello Hollywoodiano e non ti importa dell'audio.

Tutorial: Come usare LTX-2 (Online vs Locale)

Hai due opzioni per eseguire questo modello.

Opzione 1: Il modo più semplice (Consigliato)

Non hai bisogno di una GPU da 2000$ per usare LTX-2. Abbiamo integrato l'intero modello direttamente nella nostra piattaforma.

- Nessuna installazione richiesta.

- Generazione veloce sul nostro cloud.

- Anteprima audiovisiva istantanea.

Prova LTX-2 Online Ora (Clicca per iniziare a generare).

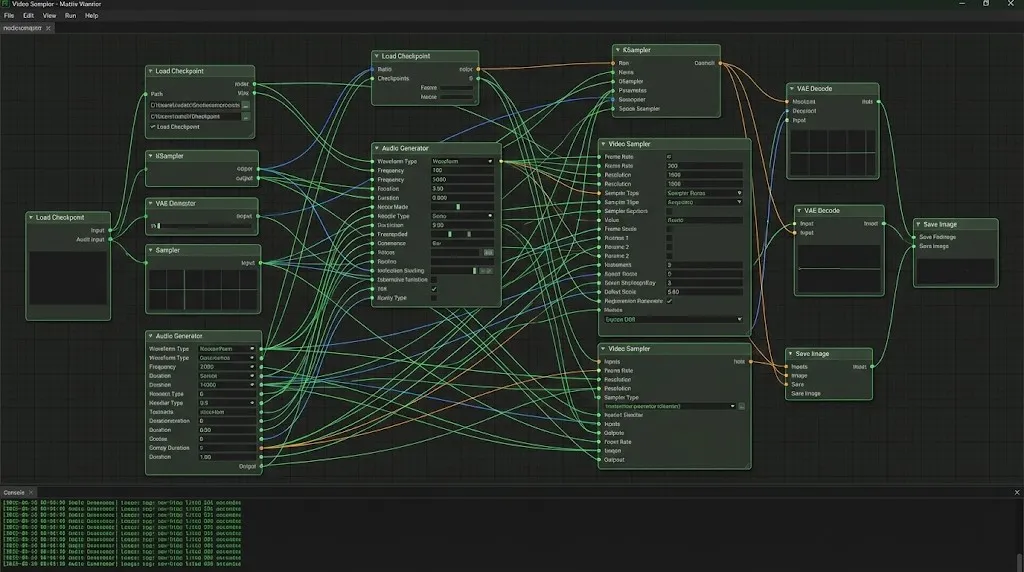

Opzione 2: Setup ComfyUI Locale (Per Sviluppatori)

Se preferisci eseguirlo localmente, segui questi passaggi:

- Installa Nodi Personalizzati: Cerca

ComfyUI-LTXVideonel Manager. - Scarica Pesi: Ottieni

ltx-video-2b-v0.9.safetensors(versione FP8) da Hugging Face. - Carica Workflow: Costruisci un workflow standard collegando il LTX Loader al Sampler.

- Genera: Imposta i frame a 97 (circa 4 secondi) e divertiti.

Pro Tip: Il setup locale richiede spesso la risoluzione di problemi con le dipendenze Python. Se incontri errori, ti consigliamo di passare al nostro strumento online per un'esperienza senza problemi.

Consigli di Prompt Engineering LTX-2

Ottenere buoni risultati richiede strategie di prompt specifiche. LTX-2 comprende sia segnali visivi che uditivi.

1. Prompt Audio-Visivi

Descrivi il suono dentro il tuo prompt visivo:

- Prompt: "A cinematic shot of a thunderstorm, lightning strikes a tree, loud thunder crack, rain pouring sound."

- Risultato: Il modello sincronizzerà il lampo di luce con il picco audio del tuono.

2. Controllo Camera

Usa questi per dirigere l'inquadratura:

LTX Video camera control prompts: "Camera pan right", "Slow zoom in", "Drone shot", "Low angle".- Esempio: "Cinematic drone shot flying over a cyberpunk city, neon lights, fog, 4k, highly detailed, electronic synthesizer music background."

3. La Lista dei Prompt Negativi

Per evitare l'effetto "faccia che si scioglie" comune nei modelli veloci, usa questa lista di prompt negativi LTX Video:

"Blurry, distorted, morphing, jittery, watermarks, text, bad anatomy, static, frozen, silence, muted."

FAQ: Risoluzione Problemi e Ottimizzazione

D: La mia generazione locale è solo uno schermo nero.

R: Questo di solito accade se stai usando il dtype VAE sbagliato. Assicurati che il tuo VAE sia impostato su bfloat16 se la tua GPU lo supporta, o float32 se sei su schede più vecchie.

D: Le impostazioni 720p di LTX-2 mandano in crash il mio PC.

R: Abilita --lowvram nel tuo file bat di ComfyUI. Inoltre, assicurati che il tuo "conteggio frame" segua la formula (8 * n) + 1 (es. 97, 121) per un allineamento tensore ottimale.

D: Posso usarlo commercialmente? R: Sì! Se le tue entrate annuali sono inferiori a 10 milioni di USD, la Licenza Community LTX-2 consente il pieno utilizzo commerciale.

Conclusione

Lightricks LTX-2 è un momento cruciale per l'AI open source. È la prima volta che abbiamo un modello che combina velocità, audio e accessibilità in un unico pacchetto.

Anche se potrebbe non battere Wan 2.1 in coerenza pixel-perfect grezza, la capacità di generare clip audiovisive sincronizzate è rivoluzionaria. Per la maggior parte dei creatori, LTX-2 è lo strumento che porta finalmente il suono alla festa dei video AI.

'Recensione Seedance 1.5 Pro: Il capolavoro audiovisivo di ByteDance con Lip-Sync perfetto'

'Mentre LTX-2 ha aperto la porta, Seedance 1.5 Pro la perfeziona. Sperimenta la generazione audiovisiva nativa, lip-sync preciso e controllo camera complesso online.'

Kling 3.0 Rilasciato: La Guida Definitiva a Funzionalità, Prezzi e Accesso

Kling 3.0 è arrivato! Esplora il nuovo motore creativo integrato con output 4K, Burst Mode da 15-second ed effetti visivi cinematografici. Scopri come accedere oggi.

Ho testato Kling 3.0 Omni: Inquadrature da 15s, Audio Nativo e la Verità su Gen-4.5

Kling 3.0 Omni è il killer di Runway Gen-4.5? Ho passato 24 ore a testare la generazione nativa di 15 secondi, la precisione del lip-sync e i controlli multi-camera. Ecco il verdetto.

Arriva Kimi k2.5: Il partner ideale per il workflow video di Kling 2.6

Kimi k2.5 è qui con comprensione video nativa e una finestra di contesto di 256k. Scopri come combinarlo con Kling 2.6 per automatizzare la tua pipeline di produzione video AI.

Z-Image Base vs Turbo: Padroneggiare il rendering del testo cinese nei video Kling 2.6

Scopri come utilizzare i modelli Z-Image Base e Turbo per risolvere i problemi di rendering del testo cinese nei video Kling 2.6. Guida completa al flusso di lavoro per casi d'uso commerciali e artistici.

'Rompere il monopolio Nvidia: come GLM-Image e il chip Huawei Ascend hanno conquistato le classifiche AI'

'Il 14 gennaio, GLM-Image, addestrato interamente su chip Huawei Ascend e framework MindSpore, ha raggiunto il 1° posto su Hugging Face Trending. Un momento cruciale per l''AI open source globale.'

'Guida Z-Image Turbo: Eseguire la bestia 6B di Alibaba in ComfyUI (Vs. FLUX)'

'Dimenticate i 24GB di VRAM. Z-Image Turbo (6B) di Alibaba offre risultati fotorealistici e rendering di testo cinese perfetto in soli 8 passaggi. Ecco la vostra guida completa al workflow ComfyUI.'

Recensione di Google Veo 3.1: La rivoluzione del 4K, del video verticale e della coerenza

Google Veo 3.1 introduce l'upscaling 4K nativo, i video verticali 9:16 e la coerenza dell'identità. Inoltre, uno sguardo al codice trapelato del modello Veo 3.2.