Kling Motion Control meistern: Der ultimative Guide zur digitalen KI-Puppenspielerei (2026)

[!NOTE] Dieser Leitfaden basiert auf der offiziellen Kling AI Motion Control Dokumentation (Stand: Januar 2026).

Kling Motion Control meistern: Der ultimative Guide zur digitalen KI-Puppenspielerei (2026)

In der sich rasant entwickelnden Landschaft der KI-Videogenerierung stellt Kling Motion Control einen Paradigmenwechsel dar: weg von der stochastischen (zufälligen) Generierung, hin zur deterministischen Kontrolle. Diese Technologie verändert die Art und Weise, wie Kreative an die „digitale Puppenspielerei“ (Digital Puppetry) herangehen, und bietet eine beispiellose Präzision bei der Charakteranimation und Bewegungsreplikation. Im Gegensatz zu herkömmlichen KI-Video-Tools, die oft auf Zufällen basieren, bietet Kling Motion Control ein systematisches Framework für konsistente, qualitativ hochwertige Ergebnisse.

Motion Control vs. Motion Brush: Den Unterschied verstehen

Die Unterscheidung zwischen Kling Motion Control und Motion Brush-Technologien ist grundlegend für das Verständnis ihrer jeweiligen Einsatzgebiete.

Motion Control arbeitet mit einem skelettbasierten Ansatz (Skeleton-driven), bei dem die KI die zugrundeliegende Knochenstruktur und die Gelenkbewegungen aus dem Referenzmaterial analysiert. Diese Methode eignet sich hervorragend für die anatomisch korrekte Replikation komplexer physischer Aktionen.

Im Gegensatz dazu folgen Motion Brush-Tools trajektorienbasierten Mustern und konzentrieren sich eher auf den Bewegungspfad als auf die strukturelle Mechanik. Während sie für einfache Animationen effektiv sind, fehlt ihnen die Präzision, die für eine realistische Replikation menschlicher Bewegungen erforderlich ist.

Die Fähigkeit des Kling Motion Control Systems, Biomechanik zu verstehen, macht es besonders wertvoll für Anwendungen, die natürliche Bewegungsmuster erfordern.

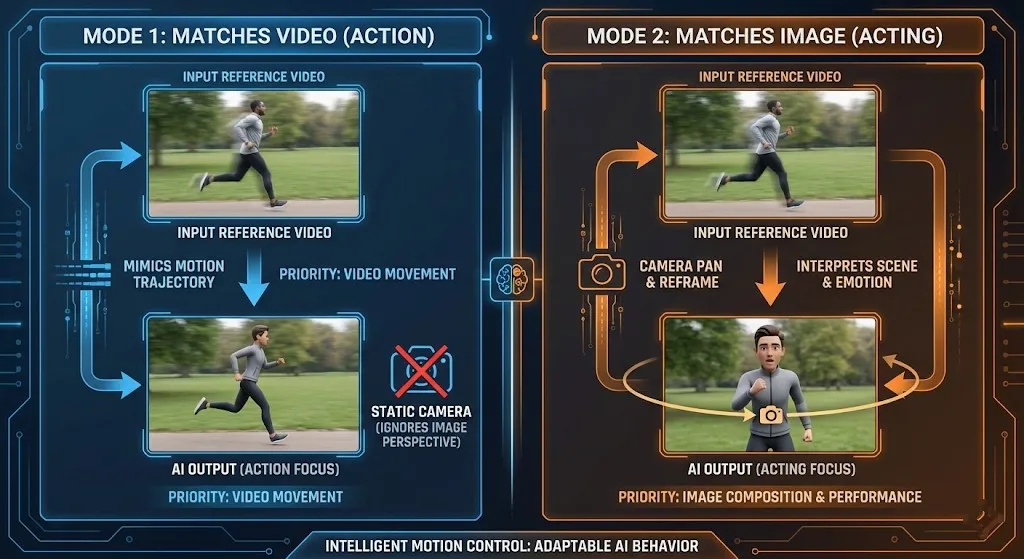

Deep Dive: Die zwei Modi der Charakterausrichtung (Character Orientation)

Modus 1: Character Orientation Matches Video (Beste Wahl für Ganzkörper-Action, Sport)

Dieser Standardmodus priorisiert die Beibehaltung der räumlichen Beziehung zwischen dem Charakter und seiner Umgebung, wie sie im Referenzvideo zu sehen ist.

Wenn Sie Character Orientation Matches Video wählen, bewahrt die KI die ursprüngliche Kameraperspektive und die Positionierung des Charakters relativ zum Hintergrund. Dieser Ansatz ist ideal für:

- Sportsequenzen, bei denen die Orientierung auf dem Spielfeld entscheidend ist

- Tanzaufführungen, die eine konsistente Bühnenpositionierung erfordern

- Action-Szenen mit komplexen Interaktionen mit der Umgebung

- Gruppenaktivitäten, bei denen räumliche Beziehungen wichtig sind

Das System analysiert die Kamerawinkel und die Platzierung der Charaktere im Referenzvideo und wendet diese räumlichen Einschränkungen dann auf Ihren generierten Inhalt an. Das stellt sicher, dass die Bewegungen innerhalb ihrer virtuellen Umgebung kontextuell angemessen bleiben.

Modus 2: Character Orientation Matches Image (Beste Wahl für Schauspiel, Kamerabewegungen)

Wenn Sie Character Orientation Matches Image wählen, priorisiert das System die ursprüngliche Pose und Ausrichtung Ihres Charakters aus dem Eingabebild. Dieser Modus ermöglicht eine kreativere Kameraführung bei gleichzeitiger Wahrung der Charakterkonsistenz.

Zu den wichtigsten Anwendungen gehören:

- Dramatische Darbietungen, die emotionale Konsistenz erfordern

- Nahaufnahmen, bei denen Gesichtsausdrücke im Vordergrund stehen

- Kamerabewegungssequenzen (Schwenks, Neigungen, Zooms)

- Charakterfokussierte Erzählungen mit minimalen Umgebungseinschränkungen

Dieser Modus entkoppelt effektiv die Charakterausrichtung von der Kameraperspektive und gibt Kreativen mehr Flexibilität im filmischen Storytelling. Die KI konzentriert sich darauf, die grundlegende Pose Ihres Charakters zu bewahren, während sich die virtuelle Kamera unabhängig bewegen kann.

Schritt-für-Schritt-Workflow für professionelle Ergebnisse

Vorbereitung: Eingabespezifikationen

Eine erfolgreiche Implementierung von Kling Motion Control beginnt mit der richtigen Vorbereitung des Inputs. Befolgen Sie diese Richtlinien für optimale Ergebnisse:

Anforderungen an das Referenzvideo:

- Dauer: 3–30 Sekunden (Idealbereich: 5–15 Sekunden)

- Auflösung: Minimum 720p, empfohlen 1080p oder höher

- Sichtbarkeit des Subjekts: Ganzkörper im Bild, keine Verdeckungen

- Bewegungsqualität: Klare, kontinuierliche Bewegung ohne Schnitte oder Sprünge

- Beleuchtung: Gleichmäßige Ausleuchtung, extreme Schatten vermeiden

Spezifikationen für das Charakterbild:

- Klarheit: Hochauflösendes Bild mit sichtbaren Gesichtszügen

- Pose: Natürlicher Stand oder eine Action-Pose, die zur beabsichtigten Bewegung passt

- Hintergrund: Einfache, unruhige Hintergründe funktionieren am besten

- Beleuchtung: Gleichmäßige Beleuchtung ohne harte Schatten

Prozess: Referenz hochladen → Modus wählen → Umgebung prompten

- Referenzvideo hochladen: Beginnen Sie mit der Auswahl eines hochwertigen Referenzclips, der das Bewegungsmuster zeigt, das Sie replizieren möchten. Stellen Sie sicher, dass das Subjekt deutlich sichtbar ist und die Bewegung kontinuierlich verläuft.

- Orientierungsmodus wählen: Wählen Sie basierend auf Ihren kreativen Zielen entweder Character Orientation Matches Video für Umgebungskonsistenz oder Character Orientation Matches Image für charakterfokussiertes Storytelling.

- Umgebungs-Prompts erstellen: Beschreiben Sie das gewünschte Setting mit spezifischer, bildhafter Sprache.

- Beispiel: "A futuristic cityscape at dusk with neon lights reflecting on wet streets" (Eine futuristische Stadtlandschaft in der Dämmerung mit Neonlichtern, die sich auf nassen Straßen spiegeln).

- Überprüfen und Generieren: Überprüfen Sie Ihre Einstellungen und starten Sie dann den Generierungsprozess. Die KI analysiert Ihre Eingaben und erstellt die bewegungsgesteuerte Sequenz.

Erweiterte Kamerasteuerung durch Prompts

Da der Modus Character Orientation Matches Image unabhängige Kamerabewegungen unterstützt, können Sie durch strategisches Prompting ausgefeilte filmische Effekte erzielen:

Schwenks (Pan Shots)

Erstellen Sie horizontale Kamerabewegungen mit Prompts wie:

- "Slow pan from left to right revealing the expansive landscape" (Langsamer Schwenk von links nach rechts, der die weite Landschaft enthüllt)

- "Quick pan following the character's movement across the room" (Schneller Schwenk, der der Bewegung des Charakters durch den Raum folgt)

- "Gentle pan establishing the environment before focusing on the subject" (Sanfter Schwenk, der die Umgebung etabliert, bevor er auf das Subjekt fokussiert)

Neigungen (Tilt Movements)

Implementieren Sie vertikale Kamerawinkel mit Beschreibungen wie:

- "Low-angle tilt upward emphasizing the character's stature" (Neigung aus der Froschperspektive nach oben, um die Statur des Charakters zu betonen)

- "High-angle tilt downward creating a sense of vulnerability" (Neigung aus der Vogelperspektive nach unten, um ein Gefühl der Verletzlichkeit zu erzeugen)

- "Dutch tilt for dramatic, disorienting effect" (Dutch Angle / gekippte Kamera für einen dramatischen, desorientierenden Effekt)

Zoom-Effekte

Steuern Sie Brennweitenänderungen mit Prompts wie:

- "Slow zoom-in on the character's expressive face" (Langsames Hineinzoomen auf das ausdrucksstarke Gesicht des Charakters)

- "Crash zoom for sudden dramatic emphasis" (Crash-Zoom für plötzliche dramatische Betonung)

- "Dolly zoom creating vertigo effect" (Dolly-Zoom / Vertigo-Effekt für Schwindelgefühl)

Stativ-Techniken (Tripod)

Für stabile, professionelle Aufnahmen:

- "Static tripod shot with subtle camera breathing" (Statische Stativaufnahme mit subtilem „Atmen“ der Kamera)

- "Locked-off camera position with character movement" (Fixierte Kameraposition mit Charakterbewegung)

- "Steadicam-style smooth following shot" (Geschmeidige Verfolgungsaufnahme im Steadicam-Stil)

Die „versteckten“ Kosten der Perfektion

Obwohl die Stückkosten erschwinglich sind, erfordert das Erreichen von Broadcast-Qualität mit Kling Motion Control oft eine „Gacha-Mentalität“. Rechnen Sie damit, 3–5 Variationen generieren zu müssen, um eine perfekte Gliedmaßenausrichtung zu erreichen und Artefakte zu eliminieren.

Zu den häufigsten Herausforderungen gehören:

Gliedmaßen-Halluzinationen (Limb Hallucinations)

Die KI kann gelegentlich zusätzliche Gliedmaßen oder falsche Gelenkpositionen generieren. Dies tritt typischerweise auf, wenn:

- Die Referenzbewegung komplexe Überlappungen enthält

- Die Kleidung des Charakters mehrdeutige Silhouetten erzeugt

- Die Lichtverhältnisse eine klare Körperdefinition verdecken

Probleme mit der zeitlichen Konsistenz (Temporal Consistency)

Die Beibehaltung eines konsistenten Charakteraussehens über die gesamte Sequenz hinweg kann schwierig sein, insbesondere bei:

- Schnellen Bewegungssequenzen

- Komplexer Stoffdynamik

- Wechselnden Lichtverhältnissen

Integration in die Umgebung

Das nahtlose Einfügen von Charakteren in neue Umgebungen erfordert sorgfältiges Prompt-Engineering und mehrere Iterationen, um natürlich wirkende Interaktionen zu erzielen.

Fehlerbehebung: Häufige Fehlercodes

"Upper Body Not Detected" (Oberkörper nicht erkannt)

Dieser Fehler tritt auf, wenn die KI die Struktur des Oberkörpers des Subjekts nicht eindeutig identifizieren kann. Häufige Ursachen sind:

- Subjekt zu klein: Stellen Sie sicher, dass Ihr Charakter genügend Bildfläche einnimmt (empfohlen: 60–80 % der Bildhöhe).

- Verdeckte Sicht: Entfernen Sie alle Objekte, die den Oberkörper des Charakters verdecken.

- Schlechte Beleuchtung: Verbessern Sie die Ausleuchtung, um die Körperdefinition zu erhöhen.

- Komplexe Hintergründe: Verwenden Sie einfachere Hintergründe für eine bessere Erkennung.

Lösung: Nehmen Sie das Referenzmaterial erneut mit besserer Sichtbarkeit des Subjekts und besseren Lichtverhältnissen auf.

Kameradrift (Camera Drift)

Bei Verwendung des Modus Character Orientation Matches Image kann es zu Kameradrift kommen, wenn den Prompts Hinweise zur Stabilität fehlen:

- Problem: Unbeabsichtigte Kamerabewegungen oder wackeliges Bildmaterial.

- Ursachen: Mehrdeutige Bewegungsbeschreibungen, widersprüchliche Kameraanweisungen, fehlende Stabilisierungs-Prompts.

- Lösung: Fügen Sie explizite Stabilisierungsanweisungen in Ihre Prompts ein:

- "Stable camera position with no movement" (Stabile Kameraposition ohne Bewegung)

- "Locked-off shot on a tripod" (Fixierte Aufnahme auf einem Stativ)

- "Steady camera following smooth motion" (Ruhige Kamera, die einer sanften Bewegung folgt)

Best Practices für optimale Ergebnisse

Auswahl des Referenzvideos

Wählen Sie Referenzmaterial, das der beabsichtigten Komplexität Ihres Outputs entspricht.

- Für Anfänger:

- Beginnen Sie mit einfachen Geh- oder Stehbewegungen.

- Gehen Sie mit zunehmender Erfahrung zu komplexeren Aktionen über.

- Vermeiden Sie anfangs Referenzclips mit schnellen Kamerabewegungen.

Prompt Engineering

Entwickeln Sie einen systematischen Ansatz für die Erstellung von Prompts:

- Beginnen Sie mit der Umgebungsbeschreibung.

- Fügen Sie Details zur Charakteraktion hinzu.

- Spezifizieren Sie das Kameraverhalten.

- Fügen Sie Stimmungs- und Beleuchtungselemente hinzu.

Iterative Verfeinerung

Machen Sie sich die iterative Natur der KI-Videogenerierung zu eigen:

- Generieren Sie mehrere Variationen mit leichten Anpassungen am Prompt.

- Analysieren Sie jedes Ergebnis auf spezifische Verbesserungsbereiche.

- Bauen Sie eine Bibliothek erfolgreicher Prompt-Kombinationen auf.

Anwendungen in der realen Welt

Film- und Animationsproduktion

Kling Motion Control revolutioniert Pre-Visualization- und Animations-Pipelines durch:

- Reduzierung der Zeit für Charakteranimation von Wochen auf Stunden

- Ermöglichung schneller Iterationen von Bewegungskonzepten

- Bereitstellung realistischer Bewegungsreferenzen für traditionelle Animatoren

Spieleentwicklung

Spielestudios nutzen diese Technologie für:

- Schnelles Prototyping von Charakteranimationen

- Erstellung vielfältiger NPC-Bewegungsbibliotheken

- Effiziente Generierung von filmischen Zwischensequenzen (Cutscenes)

Bildungsinhalte

Pädagogen nutzen Motion Control für:

- Die Demonstration komplexer physikalischer Konzepte

- Die Erstellung fesselnder historischer Nachstellungen

- Die Produktion interaktiver Lernmaterialien

Zukünftige Entwicklungen

Da sich die Kling Motion Control Technologie weiterentwickelt, sind Fortschritte in folgenden Bereichen zu erwarten:

- Interaktionen mit mehreren Charakteren mit komplexer sozialer Dynamik

- Verbesserte Physiksimulation für realistischere Interaktionen mit der Umgebung

- Echtzeit-Steuerungsschnittstellen für Live-Performance-Anwendungen

- Plattformübergreifende Kompatibilität mit gängiger Animationssoftware

Fazit: Die Kunst der digitalen Puppenspielerei meistern

Kling Motion Control stellt einen bedeutenden Sprung in der KI-gesteuerten Animationstechnologie dar. Durch das Verständnis der Nuancen zwischen den Modi Character Orientation Matches Video und Character Orientation Matches Image können Kreative eine beispiellose Kontrolle über ihre digitalen Charaktere erlangen.

Der Schlüssel zum Erfolg liegt in der sorgfältigen Vorbereitung, strategischem Prompt-Engineering und der Akzeptanz der iterativen Natur der KI-Generierung. Auch wenn das Erreichen von Perfektion mehrere Versuche erfordern mag, sind die Ergebnisse – Charakteranimation in Kinoqualität mit realistischen Bewegungen – die Mühe wert.

Denken Sie auf Ihrer Reise mit Kling Motion Control daran, dass jede Generierung wertvolle Lernmöglichkeiten bietet. Dokumentieren Sie Ihre erfolgreichen Ansätze, analysieren Sie Ihre Herausforderungen und bauen Sie schrittweise Ihre Expertise in diesem aufregenden neuen Bereich der digitalen Content-Erstellung auf.

Bereit, Ihren kreativen Workflow zu transformieren? Beginnen Sie noch heute mit Kling Motion Control zu experimentieren und entdecken Sie die Kraft der deterministischen KI-Animation.

Z-Image Turbo Guide: Alibabas 6B-Monster in ComfyUI ausführen (Vs. FLUX)

Vergessen Sie 24 GB VRAM. Alibabas Z-Image Turbo (6B) liefert fotorealistische Ergebnisse und perfektes chinesisches Text-Rendering in nur 8 Schritten. Hier ist Ihr kompletter ComfyUI-Workflow-Guide.

Kling 2.6 & Niji 7 Workflow: Erstelle virale AI-Anime-Dramen (Guide 2026)

Meistere den ultimativen AI-Anime-Workflow, der die visuelle Qualität von Niji 7 mit der Native Audio- und Motion-Control-Technologie von Kling 2.6 kombiniert. Eine Schritt-für-Schritt-Anleitung für virale Manga-Dramen.

5 Geheime Prompts für kinematografische Aufnahmen im Hollywood-Stil

Probleme mit flacher Beleuchtung? Verwenden Sie diese Copy-Paste-Prompt-Formeln, um Tiefenschärfe und dynamische Kamerawinkel zu meistern.

So optimieren Sie Seedance 2.0 Kosten: Ein Entwicklerleitfaden für 50% Einsparungen

Meistern Sie die Wirtschaftlichkeit von Seedance 2.0 mit bewährten Strategien zur Reduzierung der API-Kosten um 50%. Lernen Sie den 'Draft-Lock-Final'-Workflow und Token-Optimierungstechniken.

Seedance 2.0 Preis enthüllt: Ist der Preis von 1 RMB/Sekunde das Ende von Sora 2?

ByteDances Seedance 2.0 Preisgestaltung ist da: Hochwertige KI-Videos für nur 1 RMB pro Sekunde. Erfahren Sie, wie diese Preisstruktur Sora 2 herausfordert und die Branche neu gestaltet.

Kling 3.0 ist live: Native Audio & 15s Videos (Plus: ByteDances Seedance 2.0 ist da)

Großes Update: Kling 3.0 ist jetzt mit nativer Audio und 15s Dauer live. Außerdem stellen wir ByteDances Seedance 2.0 vor, das neue multimodale AI-Video-Monster. Probieren Sie beide noch heute aus.

Kling 3.0 vs. Runway Gen-4.5: Der ultimative KI-Video-Showdown (Vergleich 2026)

Ein umfassender Vergleich für 2026. Wir testen Kling 3.0 vs. Runway Gen-4.5 (Flagship) und Kling 2.6 vs. Gen-4 (Standard). Entdecken Sie, welcher KI-Videogenerator die besten täglichen kostenlosen Credits bietet.

Warum Seedance 2.0 entfernt wurde? Die Wahrheit hinter dem StormCrew-Video & Kling 3.0s Niederlage

StormCrews Review löste einen Panik-Bann von Seedance 2.0 aus. Erfahren Sie, warum dessen 10-fache Kosteneffizienz und Destillationstechnologie Kling 3.0 vernichten.