Kling 2.6 Ultimative Anleitung: Motion Control, Lip Sync und Modell-Download meistern

Kling 2.6 stellt einen bedeutenden Fortschritt in der KI-Videogenerierungstechnologie dar und bietet beispiellose Kontrolle über Bewegung, Synchronisation und visuelle Qualität. Als neueste Iteration von Klings leistungsstarker Videogenerierungsplattform führt Kling 2.6 bahnbrechende Funktionen ein, die neue Standards in der Branche setzen. Egal, ob Sie Content-Ersteller, Entwickler oder KI-Enthusiast sind - das Verständnis der Fähigkeiten von Kling 2.6 ist essentiell, um in der sich schnell entwickelnden Landschaft der KI-gestützten Videoproduktion die Nase vorn zu behalten.

Diese umfassende Kling 2.6-Anleitung führt Sie durch alles, was Sie wissen müssen, um die erweiterten Funktionen der Plattform zu nutzen - von der Beherrschung der Bewegungssteuerung bis zum lokalen Zugriff auf das Modell. Wir untersuchen praktische Anwendungen, technische Implementierungsdetails und wie Kling 2.6 im Vergleich zu konkurrierenden Lösungen auf dem Markt abschneidet.

Warum Kling 2.6 ein Game Changer in der KI-Video ist

Die Veröffentlichung von Kling 2.6 markiert einen entscheidenden Moment in der KI-Videogenerierung und führt Fähigkeiten ein, die zuvor für unmöglich gehalten wurden. Die verbesserte Architektur der Plattform bietet im Vergleich zu früheren Versionen überlegene zeitliche Konsistenz, glattere Bewegungsübergänge und präzisere Objektverfolgung. Kling 2.6s verbessertes Verständnis räumlicher Beziehungen und physikalischer Simulation führt zu Videos, die natürlicher und filmischer wirken.

Was Kling 2.6 auszeichnet, ist sein Fokus auf Benutzerkontrolle. Während viele KI-Video-Tools als Blackbox funktionieren, bietet Kling 2.6 granulare Kontrolle über Kamerabewegungen, Objektverhalten und Szenenzusammensetzung. Diese Kontrollebene macht es besonders wertvoll für professionelle Videoproduktions-Workflows, bei denen kreative Ausrichtung und technische Präzision von größter Bedeutung sind.

Die verbesserte Rendering-Engine der Plattform unterstützt hochauflösende Ausgaben (bis zu 1080p) mit verbesserten Bildraten, was sie für professionelle Anwendungen geeignet macht - von Marketing-Inhalten bis zu Bildungsmaterialien. Kling 2.6 führt auch erweiterte Style-Transfer-Fähigkeiten ein, die es Benutzern ermöglichen, konsistente visuelle Ästhetik über mehrere Videogenerierungen hinweg anzuwenden.

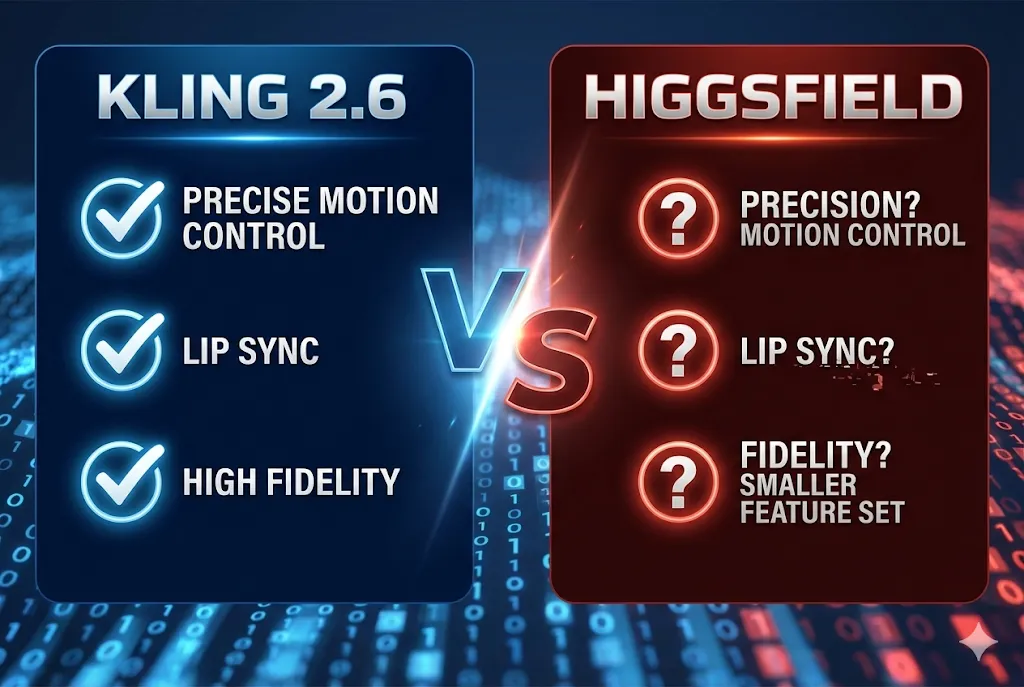

Kling 2.6 vs Unlimited Higgsfield: Ein schneller Vergleich

Bei der Bewertung von Kling 2.6 unlimited Higgsfield tauchen mehrere Schlüsselunterschiede auf, die beeinflussen, welche Plattform für bestimmte Anwendungsfälle besser geeignet sein könnte. Kling 2.6 zeichnet sich durch die Bereitstellung fein abgestimmter Kontrolle über Kamerabewegungen und Objektbewegungen aus, während sich Higgsfield Unlimited mehr auf automatisierte Generierung mit weniger Benutzereingriff konzentriert.

Was die Ausgabequalität betrifft, zeigt Kling 2.6 überlegene zeitliche Kohärenz, besonders in Szenen mit komplexen Bewegungen oder mehreren Objekten. Die Motion-Control-Funktionen der Plattform ermöglichen präzise Kameraführung, die professionellen Kinematografie-Techniken sehr nahe kommt. Higgsfield Unlimited kann zwar beeindruckende Ergebnisse erzeugen, erfordert aber oft mehr Iterationen, um ähnliche Kontrollniveaus zu erreichen.

Ein weiterer bedeutender Unterschied liegt in der Zugänglichkeit der zugrunde liegenden Modelle. Kling 2.6 bietet flexiblere Bereitstellungsoptionen, einschließlich lokaler Ausführung über Hugging Face-Integration, während Higgsfield Unlimited hauptsächlich über cloudbasierte Dienste funktioniert. Dieser Unterschied ist entscheidend für Entwickler und Organisationen mit spezifischen Datenschutz- oder Workflow-Integrationsanforderungen.

| Funktion | Kling 2.6 | Higgsfield Unlimited |

|---|---|---|

| Motion Control-Präzision | Hoch - Volle Parameterkontrolle über Pan, Tilt, Zoom, Dolly | Niedrig - Begrenzte automatische Kamerabewegungen |

| Lip Sync-Verfügbarkeit | Ja - Fortschrittliche phonembasierte Synchronisation | Nein - Lip Sync nicht verfügbar |

| Bereitstellungsoptionen | Sowohl Lokal (Hugging Face) als auch Cloud | Nur Cloud |

| Preismodell | Kostenlose Stufe + Abonnementpläne | Nur Abonnement |

| Anpassung | Hoch - Modellarchitektur kann geändert werden | Niedrig - Black-Box-Lösung |

| Videoauflösung | Bis zu 1080p | Bis zu 720p |

| Stapelverarbeitung | Lokal unterstützt | Begrenzte Cloud-Verarbeitung |

Deep Dive in Kling Video 2.6 Motion Control

Das Motion-Control-System in Kling video 2.6 motion control stellt eines der leistungsstärksten Funktionen der Plattform dar. Im Gegensatz zu traditionellen Videogenerierungs-Tools, die statische Kamerawinkel erzeugen, ermöglicht Kling 2.6 ausgeklügelte Kamerabewegungen, die Tiefe und Dynamik zu generierten Inhalten hinzufügen. Das Motion-Control-System arbeitet mit mehreren Parametern, die unabhängig oder in Kombination angepasst werden können, um spezifische filmische Effekte zu erzielen.

Im Kern interpretiert das Motion-Control-System benutzerdefinierte Parameter, um glatte, natürlich aussehende Kamerabewegungen zu erzeugen. Dazu gehören Pan (horizontale Drehung), Tilt (vertikale Drehung), Zoom (Brennweitenänderungen) und Dolly (physische Kamerabewegung zu oder weg von Objekten). Jeder Parameter kann mit Präzision gesteuert werden, was komplexe Multi-Achsen-Bewegungen ermöglicht, die manuell schwer zu erreichen wären.

Das System umfasst auch intelligente Bewegungsprädiktionsalgorithmen, die Objektbewegungen antizipieren und Kamerabedienung entsprechend anpassen. Dies führt zu Videos, bei denen die Kamera Objekte natürlich folgt und richtige Rahmung und Fokus während der Sequenz beibehält. Die Fähigkeit des Motion-Control-Systems, Szenenzusammensetzung und Objektbeziehungen zu verstehen, macht es besonders effektiv für die Erstellung narrativer Inhalte.

Die Kamerabewegung meistern

Um Kling 2.6 Motion Control effektiv zu nutzen, ist das Verständnis der Parameterbereiche und ihrer Auswirkungen essentiell. Der Pan-Parameter reicht typischerweise von -45 bis +45 Grad, wobei positive Werte die Kamera nach rechts drehen und negative Werte nach links. Für subtile Bewegungen funktionieren Werte zwischen -10 und +10 Grad gut, während dramatischere Aufnahmen den vollen Bereich nutzen können.

Der Tilt-Parameter funktioniert ähnlich und steuert vertikale Kamerabewegungen. Werte zwischen -15 und +15 Grad sind ideal für Einstellungsaufnahmen oder allmähliche Szenenentdeckung. Die Kombination von Pan- und Tilt-Bewegungen erzeugt diagonale Kamerapfade, die visuelles Interesse hinzufügen und die Aufmerksamkeit des Betrachters durch die Szene lenken können.

Zoom-Parameter werden als Multiplikatoren der Basisbrennweite ausgedrückt. Ein Wert von 1.0 repräsentiert keinen Zoom, während Werte über 1.0 hereinzoomen und Werte unter 1.0 herauszoomen. Glatte Zoomübergänge verwenden typischerweise allmähliche Änderungen über die Dauer der Aufnahme, wobei Raten zwischen 0,5x und 2,0x für filmische Effekte am häufigsten sind.

Der Dolly-Parameter steuert physische Kamerabewegung zu oder weg von Objekten. Positive Werte bewegen die Kamera näher heran und schaffen ein Gefühl von Intimität oder Dringlichkeit, während negative Werte zurückziehen und mehr Kontext offenbaren. Die Kombination von Dolly-Bewegungen mit Zoom-Anpassungen erzeugt den klassischen "Dolly-Zoom"-Effekt, der in Filmen wie "Vertigo" populär gemacht wurde.

Für optimale Ergebnisse empfiehlt das Kling 2.6-Tutorial, mit Einzelachsenbewegungen zu beginnen, bevor mehrere Parameter kombiniert werden. Dieser Ansatz hilft Benutzern zu verstehen, wie jeder Parameter die endgültige Ausgabe beeinflusst, und ermöglicht präzisere Kontrolle beim Erstellen komplexer Kamerabewegungen.

Motion Control Parameter Schnellreferenz

| Parameter | Bereich | Am besten geeignet für... | Empfohlene Werte |

|---|---|---|---|

| Pan | -45° bis +45° | Horizontale Szenenerkundung, Objekte folgen | Subtil: -10° bis +10°, Dramatisch: -45° bis +45° |

| Tilt | -30° bis +30° | Vertikale Enthüllungen, Einstellungsaufnahmen, dramatische Winkel | Subtil: -15° bis +15°, Extrem: -30° bis +30° |

| Zoom | 0,5x bis 3,0x | Aufmerksamkeit fokussieren, Spannung erzeugen, Details offenbaren | Langsamer Zoom: 0,8x bis 1,2x, Dramatisch: 1,5x bis 2,5x |

| Dolly | -1,0 bis +1,0 | Tiefe erzeugen, intime Momente, Kontext erweitern | Subtil: -0,3 bis +0,3, Stark: -0,8 bis +0,8 |

Profis-Tipps:

- Kombinieren Sie Pan und Tilt für diagonale Kamerabewegungen, die die Aufmerksamkeit des Betrachters lenken

- Verwenden Sie Dolly Zoom (Zoom + Dolly in entgegengesetzte Richtungen) für den klassischen "Vertigo-Effekt"

- Beginnen Sie mit Einzelachsenbewegungen, bevor Sie komplexe Multi-Parameter-Kombinationen versuchen

- Testen Sie Parameter mit kürzeren Videodauern (3-5 Sekunden), bevor Sie sie auf längere Sequenzen anwenden

Empfohlene Einstellungen für filmische Aufnahmen

Hier sind einige bewährte Parameterkombinationen für die Erzielung spezifischer filmischer Effekte:

-

Drohnenaufnahme: Pan 0, Tilt -15, Zoom 0,8, Dolly 0,2

- Erzeugt eine Luftperspektive mit leichtem nach unten gerichtetem Winkel

- Perfekt für die Etablierung von Szenen und die Darstellung von Umgebungskontext

-

Dolly Zoom: Zoom 2,0 + Dolly -0,5

- Erzeugt den berühmten "Vertigo-Effekt", bei dem das Objekt die gleiche Größe behält, während der Hintergrund gedehnt oder komprimiert erscheint

- Ideal für dramatische Momente und psychologische Spannung

-

Verfolgungsaufnahme: Pan 15, Tilt 0, Zoom 1,0, Dolly 0,3

- Folgt einem Objekt, das sich horizontal durch den Rahmen bewegt

- Großartig für Action-Sequenzen und Charaktereinführungen

-

Enthüllungsaufnahme: Pan 0, Tilt 0, Zoom 0,7, Dolly -0,4

- Enthüllt allmählich mehr von der Szene beim Zurückziehen

- Effektiv für Überraschungsentdeckungen und erweiterten Erzählungsumfang

Erleben Sie das neue Feature: Kling 2.6 Lip Sync

Eines der am meisten erwarteten Funktionen in Kling 2.6 ist seine fortschrittliche Lip-Sync-Fähigkeit. Die Kling 2.6 Lip-Sync-Technologie verwendet ausgeklügelte Audioanalyse- und Gesichtsanimationsalgorithmen, um generierte Videoclips mit gesprochenem Audio zu synchronisieren. Diese Funktion eröffnet zahlreiche Möglichkeiten für Content-Ersteller - von Bildungsvideos bis zu Marketingmaterialien und Unterhaltungsinhalten.

Das Lip-Sync-System funktioniert durch die Analyse von Audioeingaben zur Identifizierung von Phonemen, Prosodie und Timing-Informationen. Es bildet dann diese Audioeigenschaften auf geeignete Gesichtsausdrücke und Mundbewegungen ab und stellt sicher, dass die Mundbewegungen des generierten Charakters natürlich mit den gesprochenen Wörtern übereinstimmen. Das System berücksichtigt auch Koartikulationseffekte, bei denen die Aussprache eines Phonems die Artikulation benachbarter Phoneme beeinflusst, was zu realistischerer Sprachanimation führt.

Was Kling 2.6s Lip-Sync besonders beeindruckend macht, ist seine Fähigkeit, verschiedene Sprachen und Sprechstile zu bewältigen. Das System wurde auf vielfältigen linguistischen Datensätzen trainiert und ermöglicht es ihm, akkurates Lip-Sync für mehrere Sprachen und Dialekte zu produzieren. Zusätzlich kann es sich an verschiedene Sprechstile anpassen - von informellen Gesprächen bis zu formellen Präsentationen - und die Animation entsprechend anpassen.

Die Lip-Sync-Funktion integriert sich nahtlos mit anderen Kling 2.6-Fähigkeiten, einschließlich Motion Control und Style Transfer. Das bedeutet, dass Benutzer Videos erstellen können, bei denen Charaktere nicht nur natürlich sprechen, sondern sich auch mit filmischer Kameraführung und konsistenter visueller Gestaltung durch Szenen bewegen.

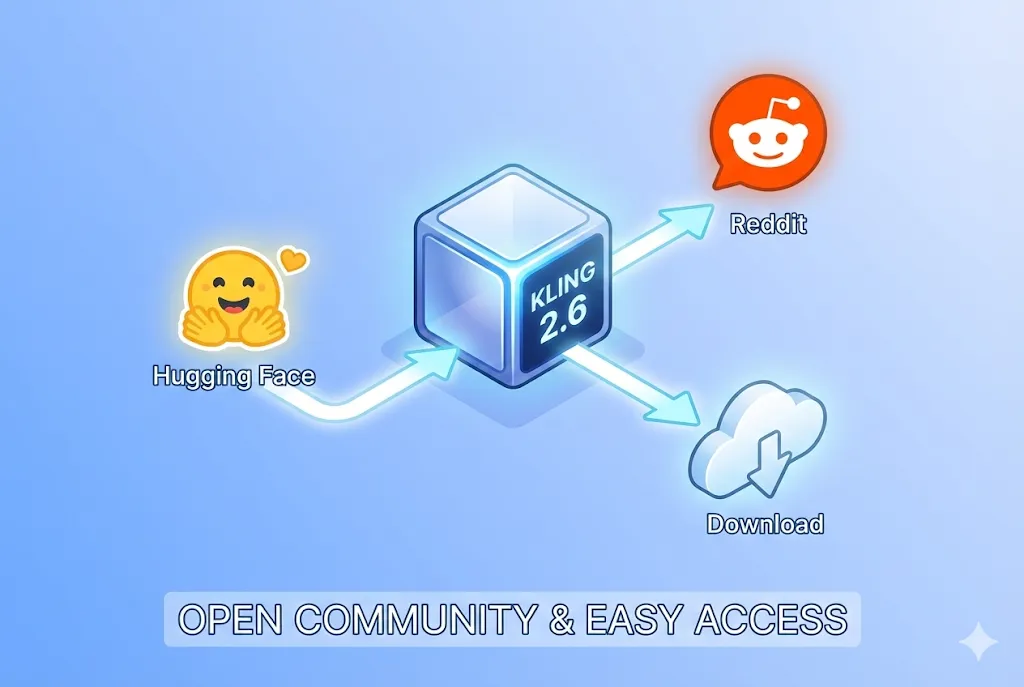

Kling 2.6 Modell-Download und Online-Zugang

Der Zugang zu Kling 2.6 kann über mehrere Kanäle erfolgen - abhängig von Ihren Anforderungen und technischem Fachwissen. Die Plattform bietet sowohl Online-Zugang über Web-Schnittstellen als auch lokale Bereitstellungsoptionen für Benutzer, die das Modell lieber auf eigener Infrastruktur ausführen möchten. Das Verständnis dieser Optionen hilft Ihnen, den Ansatz zu wählen, der am besten zu Ihrem Workflow und Ihren Anforderungen passt.

Für schnellen Zugang und Experimente bietet Kling 2.6 online eine benutzerfreundliche Web-Schnittstelle, wo Sie Videos ohne technisches Setup generieren können. Diese Option ist ideal für Benutzer, die die Fähigkeiten der Plattform erkunden oder gelegentliche Videos erstellen möchten, ohne in lokale Hardware- oder Software-Infrastruktur zu investieren. Die Online-Version umfasst alle Kernfunktionen und erhält regelmäßige Updates mit neuen Fähigkeiten.

Für Benutzer, die mehr Kontrolle, Privatsphäre oder Integration mit bestehenden Workflows benötigen, stehen Kling 2.6 Modell-Download-Optionen zur Verfügung. Das Modell kann heruntergeladen und lokal ausgeführt werden, was mehrere Vorteile bietet - einschließlich Offline-Betrieb, Datenschutz und die Möglichkeit, die Implementierung für spezifische Anwendungsfälle anzupassen. Dieser Ansatz ist besonders wertvoll für Unternehmen mit strengen Datenaufsichtsanforderungen oder Entwickler, die Anwendungen auf Basis von Kling 2.6 erstellen.

Lokal ausführen: Kling 2.6 auf Hugging Face

Für Entwickler und technische Benutzer bietet die lokale Bereitstellung von Kling 2.6 über Hugging Face maximale Flexibilität und Kontrolle. Die Kling 2.6 Hugging Face-Integration ermöglicht es Ihnen, die Modellgewichte herunterzuladen und Inferenz mit vertrauten Hugging Face-Tools und -Bibliotheken auszuführen. Dieser Ansatz ist ideal für die Integration von Kling 2.6 in bestehende ML-Pipelines oder den Aufbau kundenspezifischer Anwendungen.

Schritt-für-Schritt-Anleitung zur lokalen Bereitstellung

-

Abhängigkeiten installieren

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118 pip install transformers diffusers accelerate safetensorsStellen Sie sicher, dass Python 3.8+ installiert ist und CUDA-kompatible GPU-Treiber vorhanden sind.

-

Repository klonen

git clone https://huggingface.co/kling-ai/kling-2.6 cd kling-2.6Dies lädt die Modellkonfiguration und notwendige Dateien herunter.

-

Modellgewichte herunterladen

huggingface-cli download kling-ai/kling-2.6 --local-dir ./modelsDie Modellgewichte sind ungefähr 8GB groß. Stellen Sie sicher, dass ausreichend Speicherplatz und stabile Internetverbindung vorhanden sind.

-

Inferenz ausführen

from transformers import AutoModelForVideoGeneration, AutoProcessor import torch # Modell laden model = AutoModelForVideoGeneration.from_pretrained( "./models", torch_dtype=torch.float16, device_map="auto" ) processor = AutoProcessor.from_pretrained("./models") # Video generieren prompt = "A cinematic drone shot of a futuristic city at sunset" inputs = processor(prompt, return_tensors="pt") outputs = model.generate(**inputs, num_frames=60)

Die lokale Bereitstellung erfordert erhebliche Rechenressourcen - einschließlich einer leistungsstarken GPU mit mindestens 16GB VRAM für optimale Leistung. Systemanforderungen umfassen auch ausreichend RAM (32GB empfohlen) und Speicherplatz für die Modellgewichte und temporäre Dateien während der Generierung.

Das lokale Ausführen bietet mehrere Vorteile - einschließlich der Möglichkeit, mehrere Videos stapelweise zu verarbeiten, mit kundenspezifischen Vorverarbeitungs-Pipelines zu integrieren und die Modellarchitektur für Forschungszwecke zu modifizieren. Es erfordert jedoch auch technisches Fachwissen im Maschinellen Lernen und Softwareentwicklung.

Fehlerbehebung bei häufigen Installationsproblemen

CUDA-Speicherüberlauf-Fehler

Wenn Sie CUDA-Speicherüberlauf-Fehler während der Inferenz begegnen, versuchen Sie diese Lösungen:

-

Batch-Größe reduzieren: Verringern Sie den

num_frames-Parameter in Ihrem Generierungsskriptoutputs = model.generate(**inputs, num_frames=30) # Reduziert von 60 -

Gradient-Checkpointing aktivieren: Dies tauscht Rechenzeit gegen Speicherersparnis

model.gradient_checkpointing_enable() -

Gemischte Präzision verwenden: Stellen Sie sicher, dass Sie das Modell mit FP16 laden

model = AutoModelForVideoGeneration.from_pretrained( "./models", torch_dtype=torch.float16, device_map="auto" ) -

GPU-Cache löschen: Löschen Sie explizit Cache zwischen Generationen

torch.cuda.empty_cache()

Python-Abhängigkeitskonflikte

Abhängigkeitskonflikte sind häufig bei der Arbeit mit ML-Bibliotheken. Um sie zu lösen:

-

Virtuelle Umgebungen verwenden: Arbeiten Sie immer in einer sauberen virtuellen Umgebung

python -m venv kling-env source kling-env/bin/activate # Unter Windows: kling-env\Scripts\activate -

Spezifische Versionen festlegen: Verwenden Sie exakte Versionsnummern für kritische Abhängigkeiten

pip install torch==2.1.0 torchvision==0.16.0 torchaudio==2.1.0 --index-url https://download.pytorch.org/whl/cu118 pip install transformers==4.36.0 diffusers==0.25.0 accelerate==0.25.0 -

CUDA-Kompatibilität prüfen: Stellen Sie sicher, dass Ihre PyTorch-Version mit Ihrer CUDA-Version übereinstimmt

python -c "import torch; print(torch.version.cuda)" nvidia-smi # CUDA-Version prüfen

Modell-Download-Unterbrechungen

Große Modell-Downloads (8GB+) können aufgrund von Netzwerkproblemen fehlschlagen:

-

Fortsetzungsfähigkeit nutzen: Hugging Face CLI unterstützt das Fortsetzen unterbrochener Downloads

huggingface-cli download kling-ai/kling-2.6 --local-dir ./models --resume-download -

In Teilen herunterladen: Falls Fortsetzung nicht funktioniert, laden Sie einzelne Modellkomponenten herunter

huggingface-cli download kling-ai/kling-2.6 config.json --local-dir ./models huggingface-cli download kling-ai/kling-2.6 model.safetensors --local-dir ./models -

Mirror-Sites verwenden: Wenn der primäre Hugging Face-Server langsam ist, versuchen Sie regionale Mirrors

export HF_ENDPOINT=https://hf-mirror.com huggingface-cli download kling-ai/kling-2.6 --local-dir ./models

Leistungsoptimierungstipps

Um Generierungsgeschwindigkeit und -qualität zu verbessern:

- TensorRT verwenden: Konvertieren Sie das Modell zu TensorRT für schnellere Inferenz (nur NVIDIA GPUs)

- Stapelverarbeitung: Generieren Sie mehrere Videos parallel, wenn GPU-Speicher erlaubt

- Modell vorladen: Halten Sie das Modell im Speicher zwischen Generationen, um Nachlade-Overhead zu vermeiden

- GPU-Nutzung überwachen: Verwenden Sie

nvidia-smi -l 1, um GPU-Auslastung während der Generierung zu überwachen

Preisgestaltung und Community-Einblicke

Das Verständnis der Kostenstruktur und Community-Rezeption von Kling 2.6 ist essentiell für fundierte Entscheidungen über Adoption und Nutzung. Die Plattform bietet verschiedene Preisstufen, die entwickelt wurden, um verschiedene Benutzeranforderungen zu erfüllen - von individuellen Erstellern bis zu Unternehmenskunden.

Verständnis der Preisstruktur

Eine häufige Frage unter potenziellen Benutzern ist "Ist Kling 2.6 kostenlos?" Die Antwort hängt von Ihrem Nutzungsniveau und Anforderungen ab. Kling 2.6 bietet eine kostenlose Stufe, die begrenzten Zugang zu den Fähigkeiten der Plattform bietet und es Benutzern erlaubt, mit grundlegenden Funktionen zu experimentieren und eine kleine Anzahl von Videos monatlich zu generieren. Diese Stufe ist ideal für die Erkundung der Plattform und die Bestimmung, ob sie Ihren Anforderungen entspricht.

Für umfangreichere Nutzung bietet Kling 2.6 mehrere kostenpflichtige Abonnementstufen mit erhöhten Grenzen für Videogenerierung, Auflösung und Zugang zu Premium-Funktionen wie erweitertem Motion Control und Lip Sync. Unternehmenskunden können kundenspezifische Preisgestaltung basierend auf ihren spezifischen Anforderungen aushandeln - einschließlich dediziertem Support, SLA-Garantien und Integrationshilfe.

Kreditsystem

Kling 2.6 operiert mit einem flexiblen Kreditsystem. Hochleistungsfunktionen wie Professional Mode (1080p) und erweiterte Dauergenerierung verbrauchen mehr Kredits im Vergleich zum Standard Mode. Für die genauesten und aktuellsten Kreditverbrauchsraten beziehen Sie sich bitte auf die Echtzeitanzeige auf dem Generierungs-Dashboard.

Community-Diskussionen auf Plattformen wie Kling 2.6 free reddit liefern wertvolle Einblicke in die realweltliche Nutzung und Kosteneffektivität. Viele Benutzer berichten, dass die Preisgestaltung der Plattform wettbewerbsfähig mit ähnlichen Tools ist - besonders wenn man die erweiterten Funktionen und Ausgabequalität berücksichtigt. Der Konsens unter Power-Benutzern ist, dass Kling 2.6 gutes Preis-Leistungs-Verhältnis bietet - besonders für professionelle Anwendungen, bei denen Ausgabequalität und Kontrolle kritisch sind.

Häufig gestellte Fragen

F: Ist Kling 2.6 kostenlos?

A: Kling 2.6 bietet eine kostenlose Stufe, die es Benutzern erlaubt, bis zu 10 Videos monatlich mit Grundfunktionen zu generieren. Laut Diskussionen auf Kling 2.6 free reddit hat die kostenlose Stufe jedoch Einschränkungen bei der Videoauflösung (max. 720p) und beinhaltet nicht erweiterte Funktionen wie Lip Sync oder Motion Control. Für ernsthafte Content-Erstellung empfehlen die meisten Benutzer ein Upgrade auf die Pro-Stufe (29 $/Monat), die 1080p-Auflösung, unbegrenzte Generationen und Zugang zu allen Premium-Funktionen beinhaltet.

F: Kann ich Kling 2.6 auf einer 12GB VRAM GPU ausführen?

A: Während die offizielle Empfehlung 16GB VRAM beträgt, ist es möglich, Kling 2.6 auf einer 12GB GPU mit einigen Optimierungen auszuführen. Sie müssen:

- Gemischte Präzision (FP16) Inferenz verwenden

- Die Anzahl der generierten Frames reduzieren

- Die Videoauflösung auf 720p senken

- Gradient-Checkpointing aktivieren

- Andere GPU-intensive Anwendungen schließen

Die Leistung wird langsamer sein, und Sie können längere Generierungszeiten erleben. Für optimale Ergebnisse erwägen Sie ein Upgrade auf eine 16GB+ GPU oder verwenden Sie die Cloud-Version.

F: Wie behebe ich Audio-Synchronisationsprobleme in Kling 2.6 Lip Sync?

A: Audio-Synchronisationsprobleme werden normalerweise verursacht durch:

- Schlechte Audioqualität - Verwenden Sie saubere, rauschfreie Audioaufnahmen

- Falsche Abtastrate - Stellen Sie sicher, dass Audio 16kHz oder 44,1kHz ist

- Sprachmismatch - Das Lip-Sync-Modell ist für Englisch optimiert; andere Sprachen können leichte Verzögerungen haben

- Komplexe Sprachmuster - Schnelles Sprechen oder mehrere Sprecher können Sync-Probleme verursachen

Um Sync-Probleme zu beheben:

- Verarbeiten Sie Audio vor mit Rauschreduzierung

- Verwenden Sie ein konsistentes Sprechtempo

- Brechen Sie lange Monologe in kürzere Segmente

- Passen Sie den Sync-Offset-Parameter in der Kling 2.6-Schnittstelle an (typischerweise von -5 bis +5 Frames)

F: Was ist der Unterschied zwischen Kling 2.6 online und lokaler Bereitstellung?

A: Kling 2.6 online bietet Bequemlichkeit mit keinem Setup erforderlich, automatischen Updates und cloudbasierter Verarbeitung. Lokale Bereitstellung bietet mehr Kontrolle, Privatsphäre und die Möglichkeit, das Modell anzupassen. Wählen Sie online für schnelle Projekte und lokale Bereitstellung für Unternehmensanwendungen oder Forschungszwecke.

Fazit: Abschließende Gedanken zu Kling 2.6

Kling 2.6 repräsentiert einen bedeutenden Fortschritt in der KI-Videogenerierungstechnologie und bietet leistungsstarke Funktionen wie Motion Control und Lip Sync, die neue Standards in der Branche setzen. Die Kombination der Plattform aus benutzerfreundlichen Schnittstellen und erweiterten Fähigkeiten macht sie sowohl für Gelegenheitsbenutzer als auch professionelle Content-Ersteller zugänglich.

Egal, ob Sie sich entscheiden, Kling 2.6 online für schnelle Videogenerierung zu verwenden oder es lokal über Hugging Face-Integration für maximale Kontrolle bereitzustellen - die Plattform bietet die Werkzeuge, die benötigt werden, um hochwertige KI-generierte Videos zu erstellen. Die umfassende Kling 2.6-Dokumentation und aktive Community-Unterstützung erleichtern den Einstieg und die Beherrschung der Plattformfunktionen.

Da KI-Videogenerierung sich weiterentwickelt, sticht Kling 2.6 als vielseitige und leistungsstarke Lösung hervor, die Zugänglichkeit mit professionellen Fähigkeiten in Balance hält. Egal, ob Sie Marketing-Inhalte, Bildungsmaterialien oder Unterhaltungsvideos erstellen - Kling 2.6 bietet die Funktionen und Flexibilität, die benötigt werden, um Ihre Vision zum Leben zu erwecken.

Bereit, die Zukunft der KI-Videogenerierung zu erleben? Besuchen Sie unsere Homepage, um heute mit Kling 2.6 zu beginnen und zu entdecken, wie es Ihren Videoproduktions-Workflow transformieren kann.

Z-Image Base vs. Turbo: Meisterung chinesischer Textdarstellung in Kling 2.6 Videos

Lernen Sie, wie Sie Z-Image Base und Turbo Modelle nutzen, um Probleme bei der Darstellung chinesischer Texte in Kling 2.6 Videos zu beheben. Vollständiger Workflow-Leitfaden für kommerzielle und künstlerische Anwendungsfälle.

So optimieren Sie Seedance 2.0 Kosten: Ein Entwicklerleitfaden für 50% Einsparungen

Meistern Sie die Wirtschaftlichkeit von Seedance 2.0 mit bewährten Strategien zur Reduzierung der API-Kosten um 50%. Lernen Sie den 'Draft-Lock-Final'-Workflow und Token-Optimierungstechniken.

Seedance 2.0 Preis enthüllt: Ist der Preis von 1 RMB/Sekunde das Ende von Sora 2?

ByteDances Seedance 2.0 Preisgestaltung ist da: Hochwertige KI-Videos für nur 1 RMB pro Sekunde. Erfahren Sie, wie diese Preisstruktur Sora 2 herausfordert und die Branche neu gestaltet.

Kling 3.0 ist live: Native Audio & 15s Videos (Plus: ByteDances Seedance 2.0 ist da)

Großes Update: Kling 3.0 ist jetzt mit nativer Audio und 15s Dauer live. Außerdem stellen wir ByteDances Seedance 2.0 vor, das neue multimodale AI-Video-Monster. Probieren Sie beide noch heute aus.

Kling 3.0 vs. Runway Gen-4.5: Der ultimative KI-Video-Showdown (Vergleich 2026)

Ein umfassender Vergleich für 2026. Wir testen Kling 3.0 vs. Runway Gen-4.5 (Flagship) und Kling 2.6 vs. Gen-4 (Standard). Entdecken Sie, welcher KI-Videogenerator die besten täglichen kostenlosen Credits bietet.

Warum Seedance 2.0 entfernt wurde? Die Wahrheit hinter dem StormCrew-Video & Kling 3.0s Niederlage

StormCrews Review löste einen Panik-Bann von Seedance 2.0 aus. Erfahren Sie, warum dessen 10-fache Kosteneffizienz und Destillationstechnologie Kling 3.0 vernichten.

Kling 3 vs Seedance 2: Der definitive Technik-Report & Vergleich (2026)

Die Ära der zufälligen KI-Videos ist vorbei. Wir vergleichen die „Physik-Engine“ (Kling 3) mit dem „Narrativen System“ (Seedance 2). Welches Ökosystem dominiert 2026?

Seedance 2 Review: Ist Jimeng 2.0 das Ende der "Gacha"-KI-Videos?

Seedance 2 (Jimeng) ist da mit 4K-Auflösung und revolutionärer Storyboard-Steuerung. Wir testen, ob Seedance2 endlich das Konsistenzproblem für KI-Filmemacher löst.